Дисковая полка что это

JBOD — недорогое файловое хранилище для 2021 года

Количество информации, которую требуется хранить, увеличивается из года в год. Если раньше хватало пары десятков килобайт, то сейчас недостаточно сотен терабайт, в особо сложных случаях даже тысяч. Дешевые хранилища с ограниченными возможностями стали довольно востребованы. Хоть к скорости дисковой подсистемы тоже высоки, но в некоторых случаях необходимы недорогие хранилища без претензий на отказоустойчивость.

JBOD (аббр. Just a bunch of disk, просто куча дисков) — тип хранилища, представляющий собой набор жестких дисков, объединенных таким образом, что отображаются словно единый сетевой диск. Соответственно, ни о каких массивах речи и быть не может. Объединять отдельные дисковые полки в массивы либо создавать оный в пределах JBOD нельзя. Фактически, это самый простой тип хранилища данных. Обычный файловый набор с низкой отказоусточивостью, ведь при отказе одного HDD, негативные последствия скажутся на всей файловой системе.

На данный момент самый выгодный вариант дисковой полки можно заказать у компании Сервер Гид. У них есть варианты от производителей Supermicro и Western Digital, а это наиболее дешевые и качественные варианты на рынке.

Как устроен JBOD

Сей тип СХД довольно прост, потребуется контроллер с поддержкой одноименного режима, полка для размещения и подключения. Все диски подключаются через объединительные платы и переходники к контроллеру, который впоследствии будет этой кучей накопителей управлять.

Никто не мешает построить JBOD на базе более дорогой серверной платформы, но стоимость платформы сделает подобные вложения невыгодными. Пример ниже.

В принципе, «кучу дисков» можно создавать без подобного корпуса, что еще сильнее удешевит итоговый вариант, но стоит ли оно того, учитывая, что станет менее удобно компоновать дисковую полку и могут возникнуть проблемы размещения? Вопрос хороший, но решать вам… И бюджету.

Ладно, как выглядит это дело, вполне ясно, поговорим о более специфических вещах.

Интерфейсы

JBOD поддерживает практически все современные логические и физические интерфейсы накопителей, но ограничено применение целесообразностью, строить ДП на SSD NVMe попросту глупо и экономически нецелесообразно, потому сейчас наиболее распространены:

Наиболее популярен SATA и, как ни удивительно, практически отмерший IDE. Накопители с первым типом дешевы и дают приемлемую эффективность, SAS довольно дорог, имеет значительно меньший объем, потому применяется редко. Small Computer System Interface свое давно отжил, устройства с таким набором стандартов встречаются редко. IDE или более распространенная аббревиатура ATA – предшественник SATA и последним попросту вытеснен, но использовать в JBOD старые HDD IDE никто не мешает, что многие делают. Впрочем, найти накопители на замену трудно, потому наиболее предпочтителен SATA-интерфейс.

HDD или SSD?

Дисковая полка, исполненная на SSD вполне возможна. Ничто не мешает сделать это, кроме экономической целесообразности. Твердотельные накопители довольно дороги, а JBOD есть смысл применять только в том случае, если недостаточно денег на более эффективные типы систем хранения данных, например NAS или SAN с RAID- массивами. Потому сфера применения четко ограничена не только техническим возможностями, но и экономикой.

Контроллеры

Подойдет любой контроллер с поддержкой JBOD и внешними портами, для формирования полки нужен контроллер с внутренними портами для объединения HDD. Наиболее дешевые модели у Supermicro, WD, Huawei. Дорогие нецелесообразны. Многие RAID- контроллеры имеют встроенную поддержку объединения дисков таким методом.

Преимущества и недостатки JBOD

К несчастью, это не самый эффективный способ работы с файловыми системами. Попробую объяснить почему. Начнем с преимуществ, которых, к сожалению, не так уж много:

Низкая стоимость. Пожалуй, единственная причина, по которой дисковая полка не ушла в прошлое.

Возможность объединения накопителей с разным интерфейсом. Можно подключать HDD через HBA- контроллеры, а те присоединять к JBOD- контроллеру. Не очень просто, но если валяются не приспособленные никуда накопители, почему бы не поступить так?

Можно использовать диски с разными параметрами : скорость, вращение головки, объем. Разница в технических характеристиках скажется только на общей скорости системы. Самый медленный HDD станет ограничением по скорости для всего устройства.

Пожалуй, на сих невпечатляющих преимуществах список можно и закончить. Как видите, ничего выдающегося нет, зато недостатки вполне впечатляющие:

Файловую систему требуется постоянно дефрагментировать, если фрагменты файлов будут разбросаны по разным накопителям, то выход из строя одного, затронет и другие. К тому же, серьезная фрагментация плохо скажется на скорости.

Максимальная скорость массива определяется самым медленным жестким диском, потому нет смысла ставить производительные диски в комплекте с менее шустрыми. Конечно, скорость HDD давно серьезно не менялась, но современные диски работают немного быстрее.

Отказ одного диска не затронет файловое пространство других, но данные на нем безвозвратно потеряются, если не сделана резервная копия. Потому, если фрагменты разбросаны по разным накопителям, и часть фрагментированного файла будет на отказавшем диске, он будет поврежден.

Отсутствие RAID. К сожалению, JBOD всего лишь сетевой диск, массивом в полной мере подобная система не является.

Плохая защита данных. Защитить можно только извне посредством сервера или другой вычислительной техники.

В целом, простой тип СХД. Никаких изысков, а простая дисковая полка. Подойдет в качестве файлового хранилища для всякой ерунды. В силу плохой встроенной защиты данных и невозможности обеспечить полноценную сохранность информации, использовать рекомендуется только для несерьезных задач.

Перспективы JBOD в 2021 году

Дисковые полки будут еще долго востребованы. Они дешевы и не требуют серьезных усилий в обслуживании конфигурации. В качестве места размещения архивных данных использовать можно. Единственный недостаток — низкий уровень отказоустойчивости, но с этим ничего не поделаешь. Формирование RAID станет более дорогим удовольствием.

В этот период времени сферы приложения для устройства найдутся. Главное, отдавать себе отчет в том, что для хранения важной информации подобная платформа не подходит. А вот в качестве файлопомойки для офиса — вариант идеальный.

Выводы

JBOD – полезная вещь, если нет серьезных требований к сохранности данных и надежности. Можно туда скидывать старые бэкапы, всякий ненужный хлам, который удалить жалко, но и держать смысла нет и прочую информацию, которая в перспективе не пригодится вообще. Кстати, наиболее выгодные варианты по дисковым полкам сейчас предоставляет компания «Сервер Гид». Сэкономите много времени и средств, если обратитесь к ним.

Как выбрать дисковую полку (JBOD)

Дисковая полка (ее также называют JBOD) — это оборудование для серверной, которое используется для хранения данных.

В тех же целях используются системы хранения данных (СХД), но между ними есть довольно большая разница:

Эта разница и заложена в название: JBOD расшифровывается как Just a Bunch of Discs, что означает «просто набор дисков». Основной функционал дисковой полки — это передача данных из накопителя на сервер через адаптер (RAID или HBA).

В некоторых случаях дисковые полки поддерживают накопители любого объема и любого производителя — никаких ограничений в подборе накопителей нет, кроме вместимости самой полки и формата дисков (2.5 или 3.5 дюймов). Однако с вендорными полками ситуация обратная — они работают только с дисками того же вендора и только с ограниченным списком моделей.

Как и к любому другому серверному оборудованию, к полкам предъявляются серьезные требования. Вся система должна быть надежной и отказоустойчивой: необходимы надежные блоки питания и достаточное охлаждение для дисков.

Таким образом, дисковая полка — это выгодное решение в тех случаях, когда нужно радикально расширить пространство для хранения данных без затрат на новый дополнительный сервер. В таком случае вы приобретаете дисковую полку, устанавливаете в нее накопители и подключаете полку к уже имеющемся серверу.

Если одной серверной полки недостаточно, доступно каскадное подключение одной полки к другой — таким способом можно подключить несколько полок к одному серверу.

Модели

Все модели предназначены для монтажа в серверную стойку, занимают 1U или 2U. Обычно дисковая полка вмещает 12 или 24 диска форматами 3.5 дюйма SATA III и имеет один или два блока питания мощностью до 1000 Вт.

До четырех дисков

В этой категории доступна одна модель — Synology RX418. Полка позволяет установить до четырех дисков с возможностью горячей замены. Эта модель оснащена одним блоком питания мощностью 100 Вт и занимает 1U в серверной стойке.

До двенадцати дисков

Модели на двенадцать дисков занимают в серверной стойке по 2U. Вот некоторые из них:

— Synology RX1217 — полка поддерживает горячую замену, оснащена внешним интерфейсом подключения Infiniband и одним блоком питания мощностью 500 Вт. Также есть похожая модель, но с двумя блоками питания — Synology RX1217RP.

— HP Enterprise D3610 — полка с внешним интерфейсом подключения SAS 12 и двумя блоками питания мощностью 460 Вт.

Если вам нужно готовое решение, вы можете приобрести дисковую полку с уже предустановленными накопителями.

Во всех перечисленных ниже моделях установлено от 6 до 12 жестких дисков формата SATA III (6Gb/s) 3.5 дюйма с возможностью горячей замены. Дисковые полки оснащены внешним интерфейсом подключения miniSAS HD (12Gb/s) и двумя блоками питания на 740 Вт. В стойке занимают 2U. Такие модели отличаются количеством и объемом предустановленных дисков:

До 24/25 дисков

Обе дисковые полки рассчитаны на диски форматом 2.5 дюйма и выполнены в корпусе размером 2U:

Lenovo ThinkSystem DE240S Expansion Enclosure позволяет установить до 24 дисков и имеет два блока питания мощностью 913 Вт;

HP Enterprise D3710 позволяет установить до 25 дисков формата 2.5 дюйма. Имеет внешний интерфейс подключения SAS 12 и два блока питания мощностью 460 Вт.

Современные дисковые полки в высоком ценовом сегменте поддерживают хранение до 69 петабайт

Разница между СХД и полкой и что такое JBOD

А. Сервер

B. Система хранения данных (СХД)

C. Дисковая полка SAS-1 c двумя контроллерами JBOD (HP MSA2000sa AJ750A)

Думаю, читатели данной статьи хорошо знают, что такое сервер, но имеют смутное представление об СХД и полках. СХД и полка похожи, но тем не менее между ними существенная разница.

СХД (система хранения данных) намного сложнее полки, они дороже и имеют значительно больше нюансов.

Отличие СХД от полки это наличие “Мозга”. Контроллеры СХД это мини-серверы, со своими процессорами, памятью и операционной системой. СХД собирают из дисков RAID массивы, и передают данные по протоколам высокого уровня (iSCSI, NFS), контролируют целостность данных, позволяют создавать снапшоты и многое другое. СХД нужна если наша задача построить отказоустойчивый кластер

Так выглядит подключение дисков внутри сервера

Так подключение сервер + полка.

Вот широко распространённый RAID контроллер LSI9260-8i

8i означает 8 внутренних портов SAS/SATA

А вот его брат LSI9280-4i4e

4 внутренних и 4 внешних порта

Еще несколько нюансов

Полки бывают не только SAS, но других типов, например FC (скорее всего они вам не нужны).

Полки могут быть 3, 6 и 12Gb/s. Не все знают, что в одном кабеле mini-SAS четыре канала. Это значит, что для вычисления скорости обмена полка-контроллер показатель 3,6,12 нужно умножить на 4, а в случае если полка и контроллер соединяются двумя кабелями, на 8. Для примера 3-х гигабитная полка сможет отдавать в сервер 3×4 = 12 Гигабит! Что очень неплохо, особенно, если вы устанавливаете шпиндельные накопители. Для работы диска с сервером важна не скорость передачи данных а количество операций ввода-вывода IOPS. Об этом читайте в пункте 7.

Не важно Supermicro, IBM, DELL или HP. Любая SAS полка будет работать с любым SAS контроллером. Брэнд имеет значение только когда вы подключаете полку к СХД.

*** Если вы используете SATA диски, длина подключения не должна превышать 1М.

При использовании SAS дисков (или SATA дисков с интерпозерами) можно подключать полку по двум путям, через два контроллера. Это позволяет избежать отказа в случае выхода их строя одного из контроллеров.

Полки можно добавлять по мере роста количества данных, подключая их двумя путями

“в гирлянду” вот так:

SFF* полки ( обычно бывают 2U на 24-25 дисков)

Для чего нужны SFF полки?

На увеличение IOPS положительно влияют: увеличение оборотов, уменьшение физического размера, увеличение числа дисков в массиве.

И наконец, если у вас уже есть СХД, добавив полку вы можете увеличить не только объём, но и существенно повысить скорость работы. Ведь показатель IOPS напрямую зависит от количества дисков.

У нас имеются полки для наиболее распространённых СХД производства NetAPP, HP, Dell, IBM.

Дисковые полки (JBOD). Увеличиваем место для хранения данных.

Все они поддерживают возможность горячей замены и оборудованы HDD-дисками SATA III (6Gb/s) формата 3.5″.

Важное отличие дисковой полки от системы хранения данных – это функционал.

И всем этим управляет система к которой подключена полка. Даже само название JBOD – расшифровывается как Just a Bunch of Discs, что означает «просто пачка дисков».

Но даже с таким наполнением к дисковым полкам предъявляются серьезные требования: отказоустойчивость по блокам питания, достаточное охлаждение для дисков и в некоторых случаях резервирование внутренних каналов с возможностью каскадного подключения дополнительных полок.

Первые три модели дисковых полок оснащены двумя блоками питания мощностью 740 Вт и внешним интерфейсом подключения miniSAS HD (12Gb/s). В них можно установить до 12 дисков формата 3.5″. Выполнены в корпусе для монтажа в стойку 2U.

Эти модели отличаются объемом установленных дисков:

ANDPRO-J2 — 10 дисков по 10 Тб;

ANDPRO-J3 — 12 дисков по 10 Тб.

Остальные шесть моделей дисковых полок оснащены двумя блоками питания мощностью 1400 Вт и внешним интерфейсом подключения miniSAS (6Gb/s). В них можно установить до 45 дисков формата 3.5″. Выполнены в корпусе для монтажа в стойку 4U.

Они также отличаются объемом установленных дисков:

ANDPRO-J4 — 18 дисков по 10 Тб;

ANDPRO-J5 — 24 дисков по 10 Тб;

ANDPRO-J6 — 36 дисков по 10 Тб;

ANDPRO-J7 — 40 дисков по 10 Тб;

ANDPRO-J8 — 45 дисков по 10 Тб;

ANDPRO-J9 — 12 дисков по 14 Тб;

ANDPRO-J10 — 45 дисков по 14 Тб.

Видео обзор дисковой полки Supermicro CSE-847E16-RJBOD1

Наращиваем дисковую массу без стероидов. Обзор 102-дисковой полки Western Digital Ultrastar Data102 и конфигурации СХД

Чем хороши большие JBOD’ы?

Новый JBOD Western Digital на 102 диска по 12ТБ получился мощным. При разработке этого JBOD были учтены предыдущий опыт с двумя поколениями 60-дисковых полок.

Data102 получился на редкость для таких гигантов сбалансированным по объему и производительности.

Зачем же нужны такие большие дисковые корзины, когда в мире растет популярность гиперконвергентных систем?

Задачи, при которых требования по объемам хранения значительно превышают требования по вычислительной мощности, могут раздуть бюджет заказчика до невероятных размеров. Вот лишь несколько примеров и сценариев:

Чем хорош JBOD от Western Digital?

Мы прекрасно понимаем, что модульные системы ограничены по масштабируемости возможностями контроллеров и что сеть всегда создает задержки. Но при этом такие системы обладают более низким стоимостью IOps, GBps и ТБ хранения.

Есть две вещи, за которые инженеры RAIDIX полюбили Data102:

Зря боялись. Заботясь об инженерах, в Western Digital придумали новый способ крепления диска, который позволяет облегчить обслуживание. Диски крепятся к шасси c помощью фиксирующих зажимов, без болтов и винтов. Все диски механически изолируются с помощью эластичных крепежей на задней панели. Новая прошивка сервопривода и акселерометры отлично компенсируют вибрацию.

Что у нас в коробке?

В коробке — корпус корзины, набитый дисками. Купить можно минимум 24 диска, а масштабируется решение наборами по 12 дисков. Делается это для того, чтобы обеспечить правильное охлаждение и бороться с вибрацией наилучшим образом.

Кстати, именно развитие двух вспомогательных технологий — IsoVibe и ArcticFlow — сделали возможным рождение нового JBOD’а.

Состоит IsoVibe из следующих компонентов:

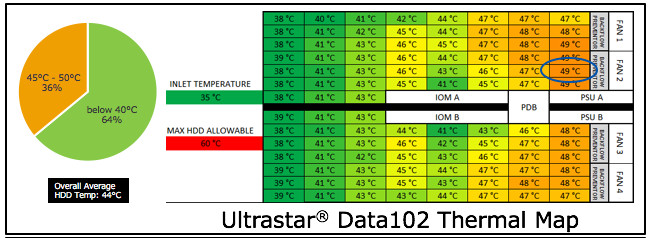

Температура — это второй после вибрации фактор, убивающий жесткие диски. При средней температуре работы выше 55C наработка на отказ жесткого диска будет в два раза меньше расчетной.

От плохого охлаждения особенно страдают серверы с большим количеством дисков и большие дисковые полки. Зачастую задние ряды дисков греются на 20 и более градусов больше, чем диски, находящиеся вблизи от холодного коридора.

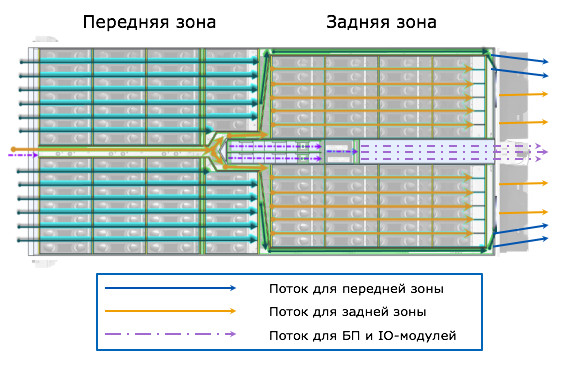

ArcticFlow — это запатентованная Western Digital технология охлаждения полки, смысл которой заключается в создании дополнительных воздуховодов внутри шасси, которые позволяют протягивать холодный воздух к задним рядам дисков напрямую из холодного коридора, минуя передние ряды.

Рис. 2. Принцип работы ArcticFlow

Отдельный поток холодного воздуха построен для охлаждения модулей ввода-вывода и блоков питания.

Результат — великолепная термальная карта работающей полки. Разброс температур между передними и задними рядами дисков — 10 градусов. Самый горячий диск — 49C при температуре в «холодном» коридоре +35C. На охлаждение каждого диска тратится 1.6Вт — в два раза меньше, чем у других подобных шасси. Вентиляторы работают тише, вибрация меньше, диски живут дольше и работают быстрее.

Рис. 3. Температурная карта Ultrastar Data 102

Учитывая бюджет по питанию в 12Вт на один диск, полку легко можно сделать гибридной — из 102 дисков 24 могут быть SAS SSD. Их можно установить и использовать как в гибридном режиме, так и настроив SAS Zoning и передав хосту, нуждающемуся в all-flash.

Еще у нас в коробке есть салазки для крепления в стойку. Для установки JBOD нужна парочка физически сильных инженеров. Вот с чем они столкнутся:

Давайте взглянем на эту систему. Спереди все просто и лаконично.

Рис. 4. Ultrastar Data 102. Вид спереди

Одной из самых интересных особенностей JBOD является установка IO-модулей сверху!

Рис. 5. Ultrastar Data 102

Рис. 6. Ultrastar Data 102. Вид сверху

Рис. 7. Ultrastar Data 102. Вид сверху без дисков

Сзади у JBOD для каждого IO-модуля есть по 6 SAS 12G портов. Итого мы получаем 28800 MBps пропускной способности бэкенда. Порты можно использовать как для подключения к хостам, так и частично для каскадирования. Портов для питания системы два (80+ Platinum rated 1600W CRPS).

Рис. 8. Ultrastar Data 102. Вид сзади

Производительность

Как мы и говорили, Data102 не просто огромен — он быстрый! Результаты тестов, проведенных вендором, таковы:

Рис. 10. Параллельная нагрузка с 6-ти серверов

Управление

Управлять JBOD со стороны софта можно двумя способами:

Это полезно использовать, если у вас диск подвешивает всю SAS-шину.

Типовые конфигурации

Для того, чтобы использовать возможности такого JBOD с максимальной пользой, нам потребуются RAID-контроллеры или программное обеспечение. Здесь на выручку и приходит ПО RAIDIX.

Для создания отказоустойчивой СХД нам потребуются два узла хранения и одна или более корзин с SAS дисками. Если же мы не хотим внедрять защиту от отказа узла или использовать репликацию данных, то можно подключить к корзине один сервер и использовать SATA диски.

Двухконтроллерная конфигурация

В качестве контроллеров для СХД на основе RAIDIX могут использоваться практически любые серверные платформы архитектуры x86: Supermicro, AIC, Dell, Lenovo, HPE и многие другие. Мы постоянно ведем работу над сертификацией нового оборудования и портируем наш код под различные архитектуры (например, «Эльбрус» и OpenPower).

Для примера возьмем платформу Supermicro и попытаемся достичь максимально возможной пропускной способности и плотности вычислений. При «сайзинге» серверов будем использовать шину PCI-E, куда установим back-end и front-end контроллеры.

Также нам понадобятся контроллеры для подключения дисковой полки, не менее двух AVAGO 9300-8e. Альтернативно: пара 9400-8e или один 9405W-16e, но для последнего понадобится полноценный слот x16.

Следующий компонент — слот для канала синхронизации. Это может быть Infiniband или SAS. (Для задач, где пропускная способность и задержки не критичны, можно обойтись синхронизацией через корзину без выделенного слота.)

Ну и, конечно, нам будут нужны слоты для хост-интерфейсов, которых тоже должно быть никак не менее двух.

Итого: каждому контроллеру нужно иметь от 5 слотов x8 (без запаса для дальнейшего масштабирования). Для построения недорогих систем, ориентированных на производительность в 3–4 ГБ/с на узел, мы можем обойтись всего двумя слотами.

Варианты конфигурации контроллеров

Supermicro 6029P-TRT

Контроллеры можно разместить в двух 2U серверах 6029P-TRT. Они не самые богатые в плане PCI-E cлотов, но зато на них установлена стандартная материнская плата без рейзеров. На этих платах гарантированно «заведутся» NVDIMM-N модули от Micron для защиты кэша от отказов питания.

Для подключения дисков возьмем Broadcom 9400 8e. Грязные сегменты кэша будем синхронизировать через IB 100Gb.

Внимание! Приведенные ниже конфигурации рассчитаны на максимальную производительность и функционирование всех имеющихся опций. Для вашей конкретной задачи спецификация может быть существенно сокращена. Обращайтесь к нашим партнерам.

Конфигурация системы, которая у нас получилась:

| № | Наименование | Описание | P/N | Кол-во на один RAIDIX DC |

|---|---|---|---|---|

| 1 | Платформа | SuperServer 6029P-TRT | SYS-6029P-TRT | 2 |

| 2 | CPU | Intel Xeon Silver 4112 Processor | Intel Xeon Silver 4112 Processor | 4 |

| 3 | Memory | 16GB PC4-21300 2666MHz DDR4 ECC Registered DIMM Micron MTA36ASF472PZ-2G6D1 | MEM-DR416L-CL06-ER26 | 12 |

| 4 | System Disk | SanDisk Extreme PRO 240GB | SDSSDXPS-240G-G25 | 4 |

| 5 | Hot-swap 3.5″ to 2.5″ SATA/SAS Drive Trays | Tool-less black hot-swap 3.5-to-2.5 converter HDD drive tray (Red tab) | MCP-220-00118-0B | 4 |

| 6 | HBA for cache-sync | Mellanox ConnectX-4 VPI adapter card, EDR IB (100Gb/s), dual-port QSFP28, PCIe3.0 x16 | MCX456A-ECAT | 2 |

| 7 | HBA for JBOD connection | Broadcom HBA 9400-8e Tri-Mode Storage Adapter | 05-50013-01 | 4 |

| 8 | Ethernet patchcord | Ethernet patch cord for cache sync 0.5m | 1 | |

| 9 | Cable for cache sync | Mellanox passive copper cable, VPI, EDR 1m | MCP1600-E001 | 2 |

| 10 | HBA for host connection | Mellanox ConnectX-4 VPI adapter card, EDR IB (100Gb/s), dual-port QSFP28, PCIe3.0 x16 | MCX456A-ECAT | 2 |

| 11 | SAS cable | Storage Enclosure Ultrastar Data102 Cable IO HD mini-SAS to HD mini-SAS 2m 2Pack | 8 | |

| 12 | JBOD | Ultrastar Data102 | 1 | |

| 13 | RAIDIX | RAIDIX 4.6 DC/NAS/iSCSI/FC/SAS/IB/SSD-cache/QoSmic/SanOpt/Extended 5 years support/unlimited disks/ | RX46DSMMC-NALL-SQ0S-P5 | 1 |

Вот примерная схема:

Рис. 11. Конфигурация на базе Supermicro 6029P-TRT

Supermicro 2029BT-DNR

Если мы хотим побороться за пространство в серверной, то за основу контроллеров хранения можно взять Supermicro Twin, например, 2029BT-DNR. Данные системы имеют по 3 PCI-E слота и по одному IOM-модулю. Среди IOM есть нужный нам Infiniband.

Конфигурация:

| № | Наименование | Описание | P/N | Кол-во на один RAIDIX DC |

|---|---|---|---|---|

| 1 | Платформа | SuperServer 2029BT-DNR | SYS-2029BT-DNR | 1 |

| 2 | CPU | Intel Xeon Silver 4112 Processor | Intel Xeon Silver 4112 Processor | 4 |

| 3 | Memory | 16GB PC4-21300 2666MHz DDR4 ECC Registered DIMM Micron MTA36ASF472PZ-2G6D1 | MEM-DR416L-CL06-ER26 | 12 |

| 4 | System Disk | Supermicro SSD-DM032-PHI | SSD-DM032-PHI | 2 |

| 5 | HBA for cache-sync | Mellanox ConnectX-4 VPI adapter card, EDR IB (100Gb/s), dual-port QSFP28, PCIe3.0 x16 | MCX456A-ECAT | 2 |

| 6 | HBA for JBOD connection | Broadcom HBA 9405W-16e Tri-Mode Storage Adapter | 05-50044-00 | 2 |

| 7 | Ethernet patchcord | Ethernet patch cord for cache sync 0.5m | 1 | |

| 8 | Cable for cache sync | Mellanox passive copper cable, VPI, EDR 1m | MCP1600-E001 | 2 |

| 9 | HBA for host connection | Mellanox ConnectX-4 VPI adapter card, EDR IB (100Gb/s), dual-port QSFP28, PCIe3.0 x16 | MCX456A-ECAT | 2 |

| 10 | SAS cable | Storage Enclosure Ultrastar Data102 Cable IO HD mini-SAS to HD mini-SAS 2m 2Pack | 8 | |

| 11 | JBOD | Ultrastar Data102 | 1 | |

| 12 | RAIDIX | RAIDIX 4.6 DC/NAS/iSCSI/FC/SAS/IB/SSD-cache/QoSmic/SanOpt/Extended 5 years support/unlimited disks | RX46DSMMC-NALL-SQ0S-P5 | 1 |

Вот примерная схема:

Рис. 12. Конфигурация на базе Supermicro 2029BT-DNR

Платформа 1U

Часто возникают задачи, где требуется максимальная плотность размещения больших объемов данных, но не требуется, например, полная отказоустойчивость по контроллерам. В этом случае мы берем за основу систему 1U и подключаем к ней максимальное количество дисковых полок.

Scale-Out система

В качестве последнего упражнения в нашей тренировке построим горизонтально-масштабируемую систему на основе HyperFS. Для начала мы выберем 2 типа контроллеров – для хранения данных и для хранения метаданных.

Контроллерами хранения назначим SuperMicro 6029P-TRT.

Для хранения метаданных используем несколько SSD накопителей в корзине, которые мы объединим в RAID и отдадим MDC через SAN. На одну систему хранения мы можем подключить до 4 JBOD каскадом. Итого в одной глубокой стойке размещаем X PB данных с единым пространством имен.

| № | Наименование | Описание | P/N | Кол-во на один RAIDIX DC |

|---|---|---|---|---|

| 1 | Платформа | SuperServer 6029P-TRT | SYS-6029P-TRT | 2 |

| 2 | CPU | Intel Xeon Silver 4112 Processor | Intel Xeon Silver 4112 Processor | 4 |

| 3 | Memory | 16GB PC4-21300 2666MHz DDR4 ECC Registered DIMM Micron MTA36ASF472PZ-2G6D1 | MEM-DR416L-CL06-ER26 | 16 |

| 4 | System Disk | SanDisk Extreme PRO 240GB | SDSSDXPS-240G-G25 | 4 |

| 5 | Hot-swap 3.5″ to 2.5″ SATA/SAS Drive Trays | Tool-less black hot-swap 3.5-to-2.5 converter HDD drive tray (Red tab) | MCP-220-00118-0B | 4 |

| 6 | HBA for cache-sync | Mellanox ConnectX-4 VPI adapter card, EDR IB (100Gb/s), dual-port QSFP28, PCIe3.0 x16 | MCX456A-ECAT | 2 |

| 7 | HBA for JBOD connection | Broadcom HBA 9400-8e Tri-Mode Storage Adapter | 05-50013-01 | 4 |

| 8 | Ethernet patchcord | Ethernet patch cord for cache sync 0.5m | 1 | |

| 9 | Cable for cache sync | Mellanox passive copper cable, VPI, EDR 1m | MCP1600-E001 | 2 |

| 10 | HBA for host connection | Mellanox ConnectX-4 VPI adapter card, EDR IB (100Gb/s), dual-port QSFP28, PCIe3.0 x16 | MCX456A-ECAT | 2 |

| 11 | SAS cable | Storage Enclosure Ultrastar Data102 Cable IO HD mini-SAS to HD mini-SAS 2m 2Pack | 8 | |

| 12 | JBOD | Ultrastar Data102 | 1 | |

| 13 | RAIDIX | RAIDIX 4.6 DC/NAS/iSCSI/FC/SAS/IB/SSD-cache/QoSmic/SanOpt/Extended 5 years support/unlimited disks/ | RX46DSMMC-NALL-SQ0S-P5 | 1 |

| 14 | Платформа (MDC HyperFS) | SuperServer 6028R-E1CR12L | SSG-6028R-E1CR12L | 1 |

| 15 | CPU (MDC HyperFS) | Intel Xeon E5-2620v4 Processor | Intel Xeon E5-2620v4 Processor | 2 |

| 16 | Memory (MDC HyperFS) | 32GB DDR4 Crucial CT32G4RFD424A 32Gb DIMM ECC Reg PC4-19200 CL17 2400MHz | CT32G4RFD424A | 4 |

| 17 | System Disk (MDC HyperFS) | SanDisk Extreme PRO 240GB | SDSSDXPS-240G-G25 | 2 |

| 18 | Hot-swap 3.5″ to 2.5″ SATA/SAS Drive Trays (MDC HyperFS) | Tool-less black hot-swap 3.5-to-2.5 converter HDD drive tray (Red tab) | MCP-220-00118-0B | 2 |

| 19 | HBA (MDC HyperFS) | Mellanox ConnectX-4 VPI adapter card, EDR IB (100Gb/s), dual-port QSFP28, PCIe3.0 x16 | MCX456A-ECAT | 1 |

Вот примерная схема подключения:

Рис. 13. Конфигурация Scale-Out системы

Заключение

Работа с большими объемами данных, особенно на write-intensive паттернах – очень непростая задача для СХД, классическим решением которой является приобретение shared-nothing scale-out систем. Новый JBOD от Western Digital и ПО RAIDIX позволит построить СХД на несколько петабайт и несколько десятков GBps производительности значительно дешевле, чем при использовании горизонтально-масштабируемых систем, и мы советуем обратить ваше внимание на такое решение.