Что такое lsi текст

Что такое LSI-фразы и почему они нужны в текстах

Технологии поискового маркетинга

Разработчики поисковых систем обращают наше внимание на то, что необходимо писать тексты для людей — полезные, интересные, информативные. И это не только слова: алгоритмы Panda и «Баден-Баден» не щадят страницы со слабым контентом и вытесняют их далеко за пределы ТОПа.

Что есть некачественный контент?

На этот вопрос мы постарались найти ответ в анализе последствий введения нового фильтра Яндекса.

Наряду с такими признаками, как

Именно об этом — качестве изложения — мы поговорим в новой статье и разберемся, при чем тут LSI-фразы и как с ними работать.

Что такое LSI

LSI-копирайтинг (LSI — аббревиатура от latent semantic indexing, что в переводе с английского языка означает «латентное семантическое индексирование») — методика написания и подачи текстового материала, повышающая его релевантность при анализе синонимов, слов, сопутствующих ключевому запросу, а также содержания и смысла текста поисковой системой.

Термин LSI стал звучать в профессиональной лексике оптимизаторов с запуском Google алгоритма Panda («Панда»). Но наиболее пристальное внимание ему стали уделять после прорыва поисковика в области семантического поиска и запуска алгоритма Hummingbird («Колибри»). Поисковая машина начала оценивать релевантность контента не столько на основании вхождения ключевого слова, сколько по степени смыслового соответствия текста исходному запросу. Над реализацией аналогичного подхода сейчас трудится и Яндекс.

Робот не просто цепляется за ключи как якоря, а сканирует и анализирует все содержание (контекст), что делает его оценку близкой к оценке человека.

В связи с этим закономерно появились термины LSI-фразы и LSI-копирайтинг. Они подразумевают расширение основного запроса, а именно: поиск его синонимов и сопутствующих тематических слов (латентных, то есть неочевидных ключей) и написание на их основе качественного материала.

Вместо расчета плотности и тошноты в дело вступает осмысленный подход, в основе которого лежит семантический анализ.

Цель этих действий — дать пользователю наиболее полный ответ на запрос, представить предметный текст в удобочитаемом виде.

Чем отличается LSI-текст от SEO-текста

Рассмотрим на примерах разницу между SEO-текстами и текстами, в которых учитывается LSI. Зададим в Яндексе запрос «купить эллиптический тренажер» и посмотрим на уровень качества контента сайтов с разных позиций.

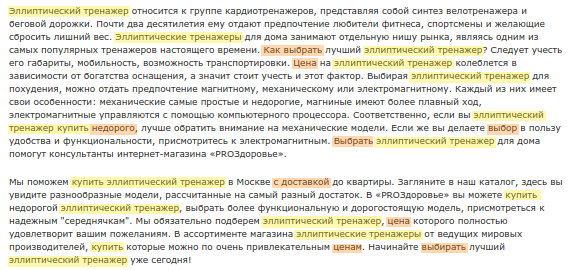

На рис. 1 — описание раздела каталога интернет-магазина за пределами ТОП50. Мы видим изобилие основного ключа (12 раз в коротком тексте!). Копирайтер в точности подогнал текст под указанные запросы, отведя информативности и удобочитаемости второстепенное значение.

На рис. 2 — текст магазина из ТОП10, претендующий называться естественным и информативным. Единственное замечание касается врезки о сервисных услугах с целью добавить на страницу ряд коммерческих ключей: «доступные цены», «большой выбор», «гарантии», «скидки», «доставка» и т. д. В данном контексте эта информация не несет полезной нагрузки.

Текст из второго примера являет собой не просто набор слов, а смысловую единицу. Если скрыть в нем основной ключевой запрос «купить эллиптический тренажер», смысл не потеряется и из контекста мы поймем, о чем идет речь. Попробуйте сделать то же самое с текстом из первого примера — можно подставить любой другой вид тренажера и ничего не изменится, что говорит о шаблонном формате контента.

Далее рассмотрим, как построить основу (найти ядро запросов) для создания качественного релевантного текста, обогащенного LSI-лексикой.

Как найти слова для LSI-ядра

Начнем с того, что LSI-фразы условно можно разбить на две категории: синонимичные и сопутствующие (связанные тематикой с основным запросом). Первая группа слов позволяет избежать многочисленных повторов ключа, вторая — раскрыть тему текста. Можно предположить, что это будут НЧ-запросы, но это не совсем верно. LSI-фразы связаны по значению с основным запросом, и в их числе могут быть разные по частотности слова и словосочетания.

В нашем примере с эллиптическими тренажерами синонимами основного ключа могут быть:

Дополняющие тематические слова:

Вопрос в том, как собрать это ядро запросов. Рассмотрим несколько бесплатных способов.

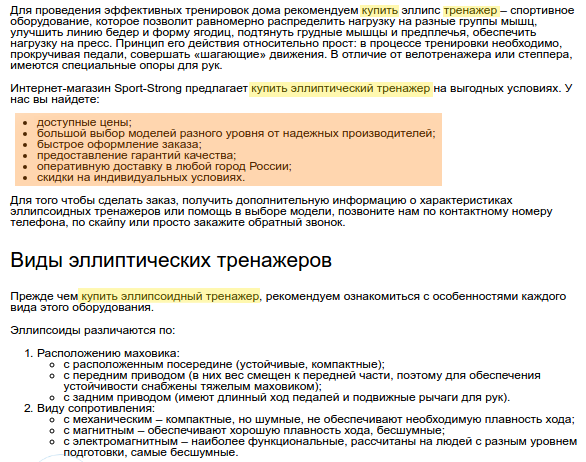

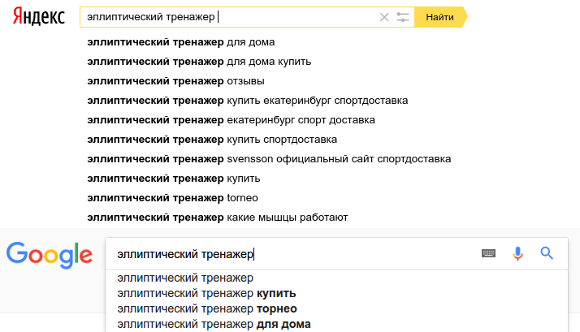

1. Поисковые подсказки

Изучаем актуальный поисковый спрос в рамках искомого запроса. Яндекс выдает десять поисковых подсказок, Google — всего три.

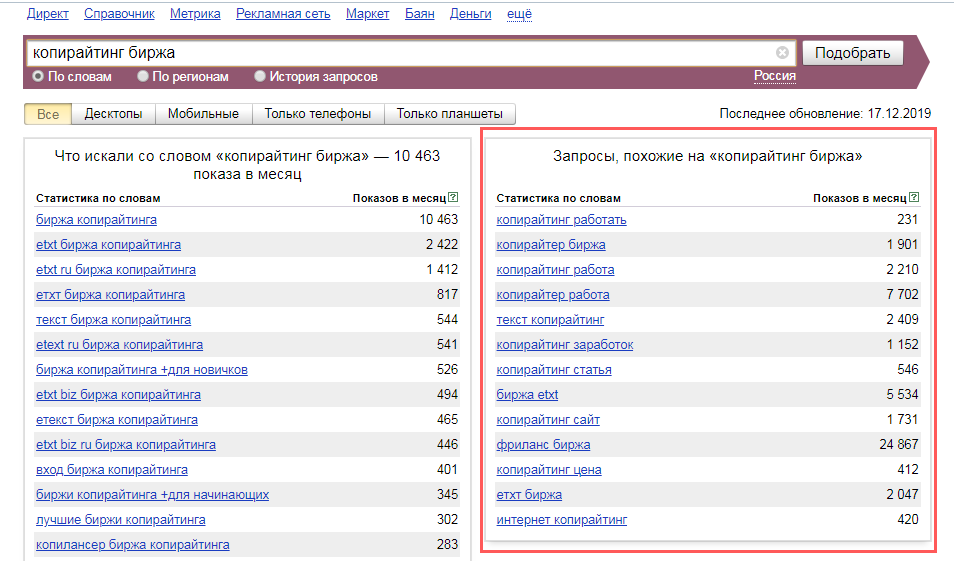

2. «Яндекс.Вордстат»

Находим «Запросы, похожие на …» в правой колонке сервиса «Вордстат» (рис.4).

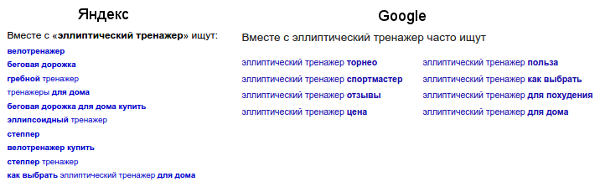

3. «Вместе с этим ищут»

Смотрим на рекомендации Яндекса и Google, основанные на других интересах людей в рамках искомого запроса. Блок располагается в нижней части страницы с результатами поисковой выдачи (рис. 5).

4. Тексты сниппетов в ТОП10

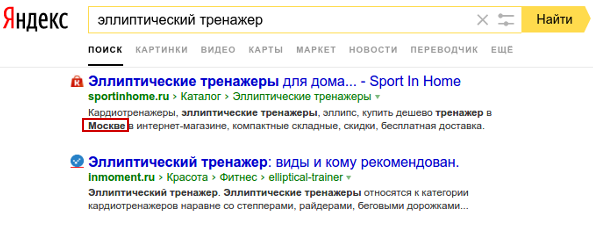

Ранее для поиска дополнительных слов можно было использовать поисковые подсветки Яндекса (выделенные слова в сниппетах наряду с искомым запросом). Однако сейчас в подсветках ничего кроме региона найти не удастся (рис. 6).

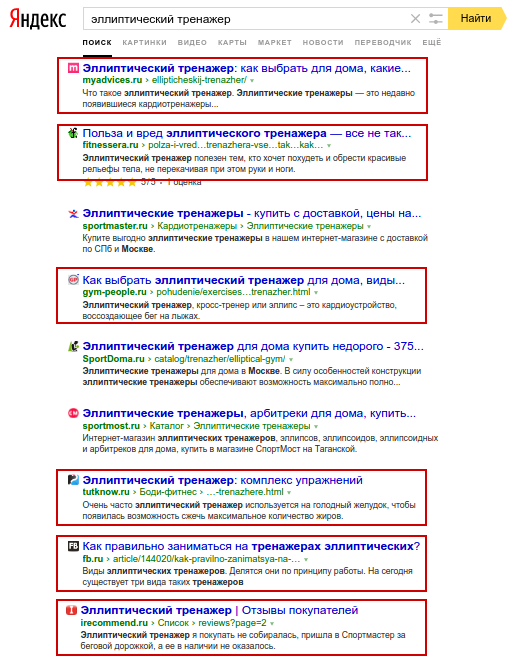

Так как подсветки более не помогают, можно использовать другой вариант работы со сниппетами — просмотреть тексты в ТОП10 и выделить наиболее часто встречающиеся слова. Важное примечание: для анализа следует брать сниппеты некоммерческих сайтов, если продвигаемый сайт является коммерческим, и наоборот (рис. 7).

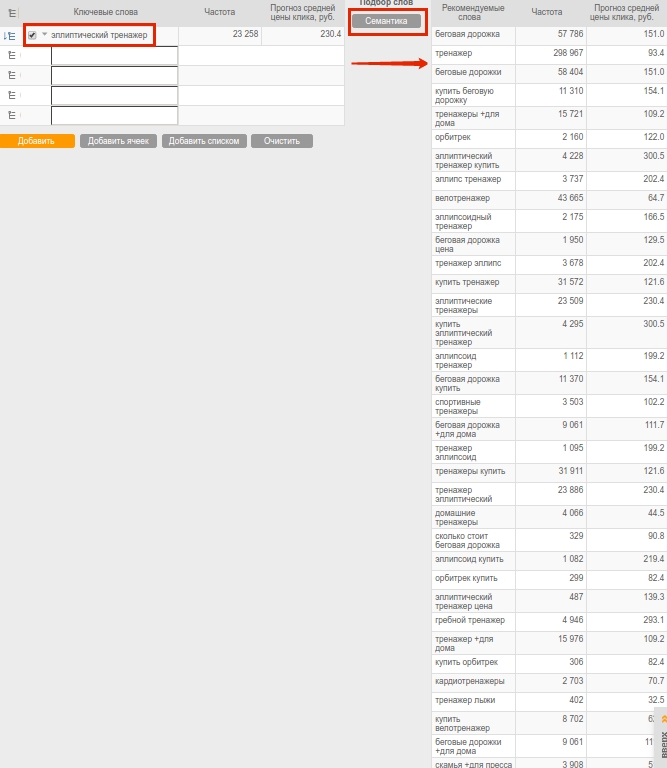

5. Генератор семантического ядра SeoPult

По сути этот инструмент агрегирует все перечисленные выше способы и исключает рутину. Указав основной запрос в ячейке и нажав кнопку «Семантика», вы за секунды получите список из нескольких десятков LSI-фраз (рис. 8). В их числе будут и синонимы, и расширяющие тематику слова. Фразы можно разбить на составляющие и брать для текста однословные запросы во избежание повторов ключа. Подборщик доступен в модуле контекстной рекламы на шаге 2, блок «Ручной подбор слов».

В результате проведенной работы вы соберете довольно широкое LSI-ядро, однако далеко не все слова будут необходимы для конкретного текста. Нужно исходить из задачи и оставлять только те запросы, которые удовлетворят требованиям. Например, описание для раздела каталога магазина и информационная статья о выборе тренажера будут иметь разное назначение и отличный набор фраз.

Найденные LSI-запросы можно использовать не только для написания новых текстов, но и коррекции существующих. После очередного текстового апдейта поисковых машин вполне вероятно, что обновленный контент появится в выдаче по дополненным ключам.

Применяй с умом

Написание текстов на основе LSI-фраз — метод рабочий, но тем не менее не решающий проблему качества контента. Можно собрать богатую семантику для насыщенной и полезной статьи, но применить ее так, что текст невозможно будет читать.

Пример на рисунке ниже является тому подтверждением.

Важно осмысленно подходить к тому, что вы пишите — не нужно превращать текст в бессвязный набор предложений.

Помните, что ключи можно использовать не только в теле текста, но также в заголовке (Title) и описании страницы (Description), заголовках H1 и подзаголовках.

Только при комплексной оптимизации и регулярном создание новых страниц сайта с тематическим контентом можно рассчитывать на внимание читателей и расположение поисковых машин. В реализации этой задачи вам помогут профессиональные копирайтеры и редакторы.

LSI-фразы: что это такое и как их собрать

Делюсь самым эффективным алгоритмом поиска LSI-фраз, которые постоянно использую в работе. В итоге вы тоже научитесь за полчаса вычислять необходимое количество LSI и находить нужные.

Что такое LSI-копирайтинг

«Пишите для людей», – говорят они. Как поисковику дать понять, что содержание мой страницы удовлетворяет желания пользователей? Эту задачу выполняет LSI-копирайтинг.

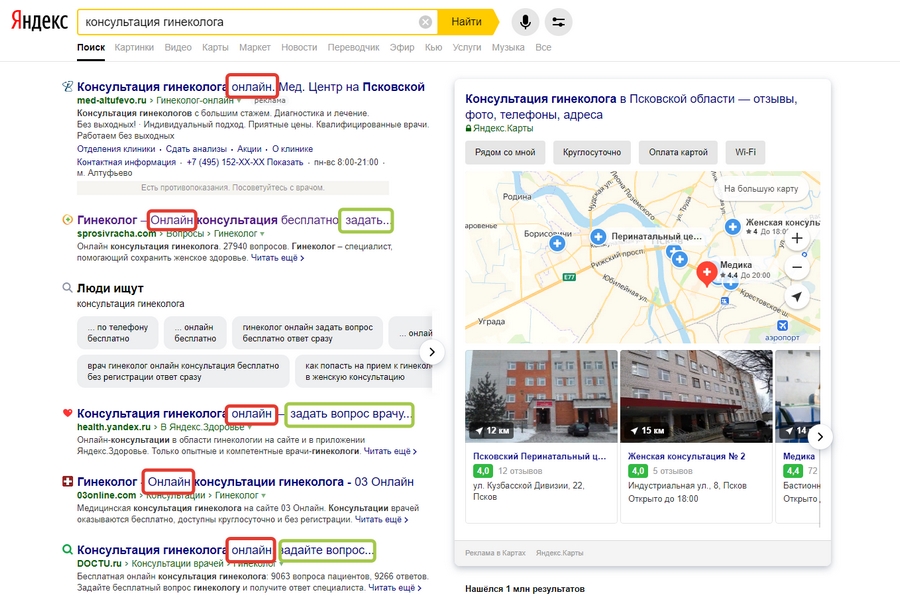

Если пользователь вводит в поисковик фразу «консультация гинеколога», он, как минимум, хочет увидеть информацию о ценах, задать уточняющий вопрос и заполнить форму записи. То есть фразы «гинеколог задать вопрос», «гинеколог цены», «запись к гинекологу» и «гинеколог онлайн» являются синонимами запроса.

Поисковик запоминает, на каких страницах пользователи задерживаются дольше и, отталкиваясь контента этих страниц, составляет список LSI-фраз. Далее при поиске он использует уже не только конкретный запрос, но и LSI-фразы.

Поисковик классифицирует страницу как коммерческую или информационную, отталкиваясь в том числе от LSI.

Сложно продвигать коммерческую страницу, если ее текстовый контент изобилует фразами, присущими информационному запросу, и наоборот. То есть LSI важен для правильной классификации страницы.

Ранжирование документов с LSI-оптимизацией и без

Между внутренними страницами сайта и внешними документами рассчитывается связь. Она похожа на связь при перелинковке и получении ссылок с других доменов, но только состоит из слов. Чем сильнее связь, тем лучше ранжируется страница. Напрямую об этом говорит патент Google (ранжирование документов с использованием словесных связей). Чем обширнее представлена LSI-семантика в документе и на сайте целиком, тем проще продвигать страницы.

Без применения LSI в конкурентных сферах делать нечего: поисковик воспримет контент сайта как недостаточно качественный, то есть неудовлетворяющий запросы.

Откуда взять LSI-семантику

Проблема 1. Как придумать синонимы и связанные фразы? Можно использовать мозговой штурм и сбор поисковых подсказок. В таком случае появляется другая проблема.

Проблема 2. Как понять, какие LSI-фразы из полученного массива имеют наибольшее значениее для поисковика?

Есть простой способ решить обе проблемы.

Шаг 1. Сбор маркерных запросов

Маркерные запросы – это костяк семантического ядра. Например, для коммерческого сайта по продаже кирпичей – «купить кирпичи», «кирпичи с доставкой» и т. д.

Базовая частотность – это сколько раз встречается фраза «купить кирпичи» во всех возможных вариациях: «купить силикатный кирпич», «купить красный кирпич дешево» и т. д.).

Точная частотность – количество конкретных запросов «купить кирпичи» без уточнений.

Чем больше разница между базовой частотностью и точным вхождением, тем больше можно сделать фраз из маркерного запроса добавляя другие слова и LSI-фразы.

Маркерные запросы имеют своей особенностью большую числовую разницу между базовой частотностью и точным вхождением фразы. Поэтому мы и ищем именно маркерные запросы по конкретному кластеру (смысловой группе) для 1 посадочный страницы.

Сформируйте и постранично сгруппируйте семантическое ядро для продолжения работы. Собирайте пока. Я пойду налью чай – вода уже закипает.

Шаг 2. Поиск конкурентов для изъятия LSI-фраз

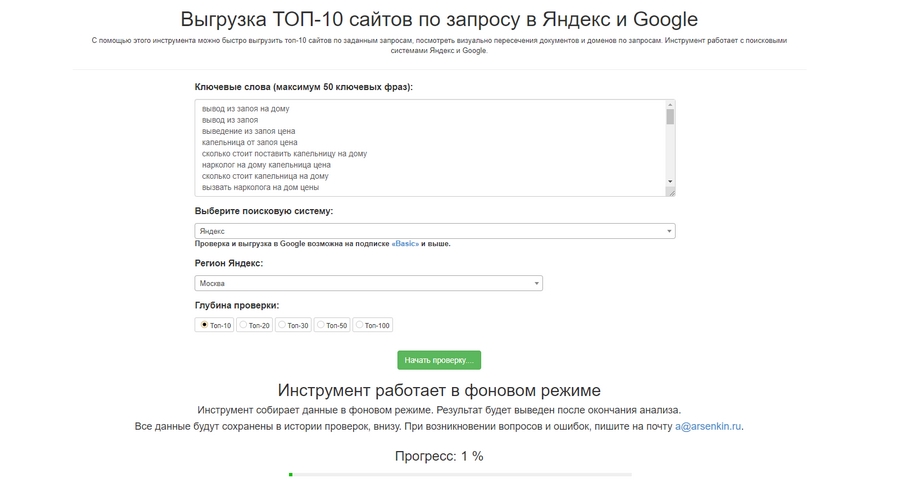

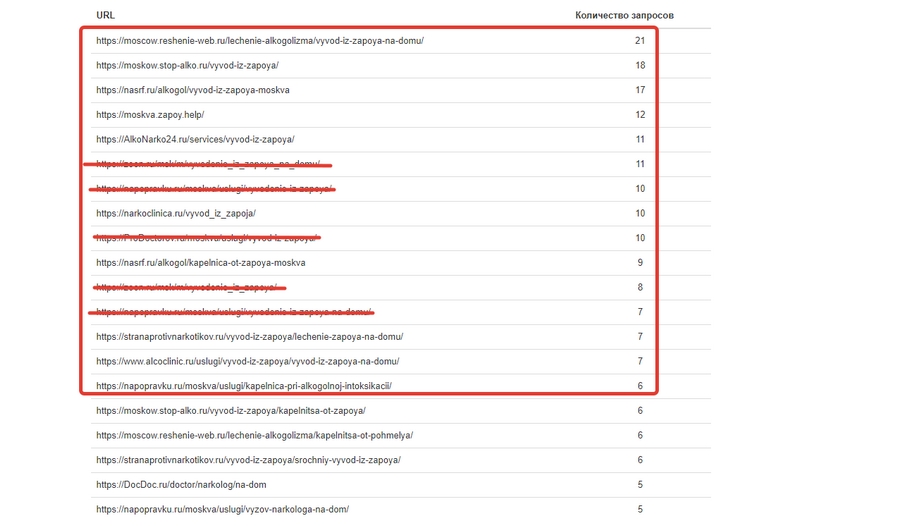

Открываем Arsenkin Tools, ищем инструмент «Выгрузка топ-10 сайтов». Забиваем туда все маркерные запросы для одной страницы, выставляем регион (всегда делайте это, даже если сайт без геопривязки) и жмем «Начать проверку».

В качестве альтернативы Arsenkin можно использовать сервисы Key Collector, PR-CY, Serpstat, Pixeltools, Topvisor.

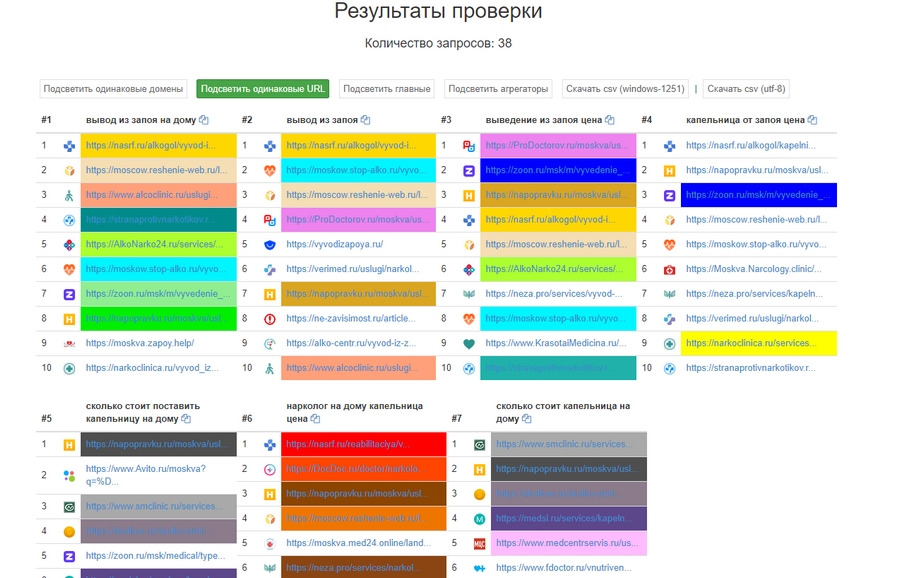

Мы получили по каждому запросу из введенного нами списка по столбику. В каждом столбике 10 сайтов из топа «Яндекса» по этому запросу. Рекламные объявления, разумеется, в столбиках отсутствуют. Столбики разноцветные: одинаковые URL, разбросанные по разным столбикам, подсвечены одним оттенком:

Наша задача – пролистать ниже до этого блока:

Как видите, я уже вычеркнул агрегаторы и выделил первые 10 подходящих ссылок. Эти страницы наиболее часто встречаются в результатах выгрузки, а значит, находятся в топе по большему количеству запросов, чем остальные. Делаем вывод, что маркерные запросы на этих страницах распарсены широко, охватывают много LSI, а страницы имеют хорошие поведенческие факторы.

Шаг 3. Таблица для исследования и веб-анализа LSI-семантики конкурентов

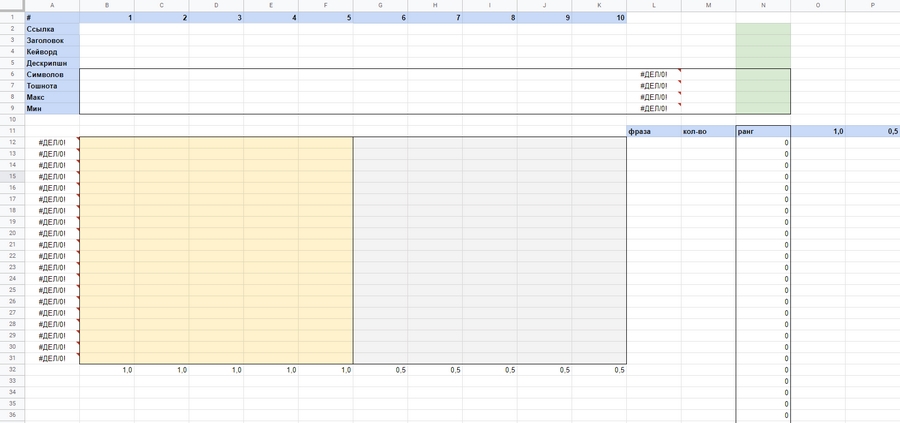

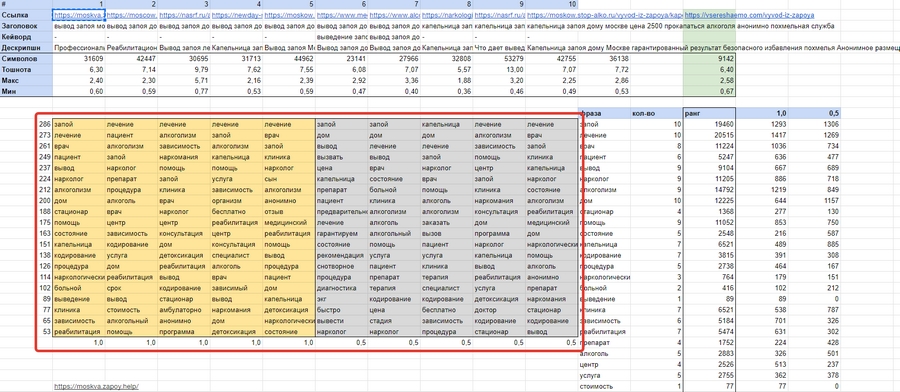

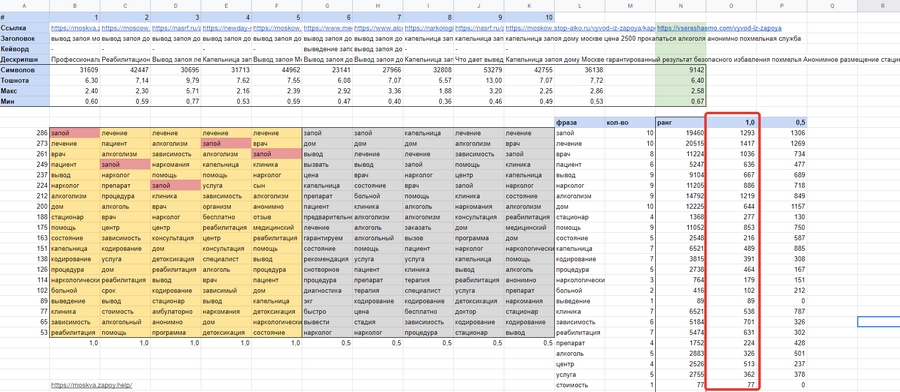

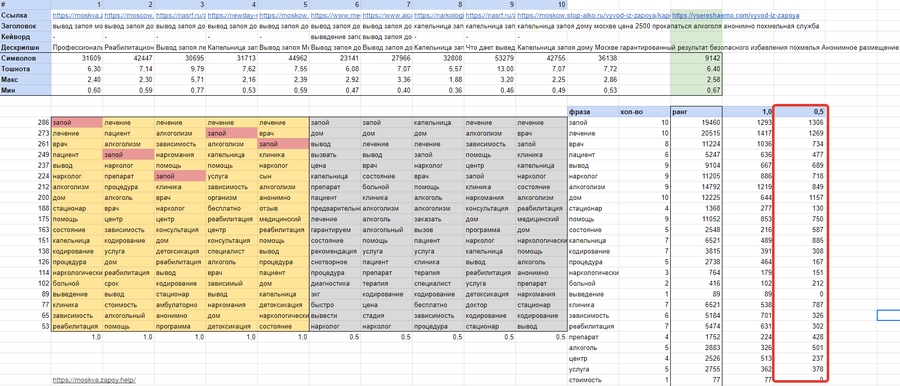

У меня было два варианта – считать все вручную для каждой страницы или внедрить формулы и сохранить шаблон для использования по мере необходимости. Я изготовил шаблон насколько мне это позволили навыки Excel. Я известный профессионал по Excel. Выглядит это вот так:

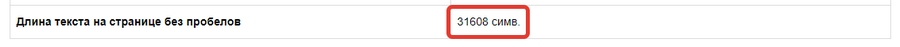

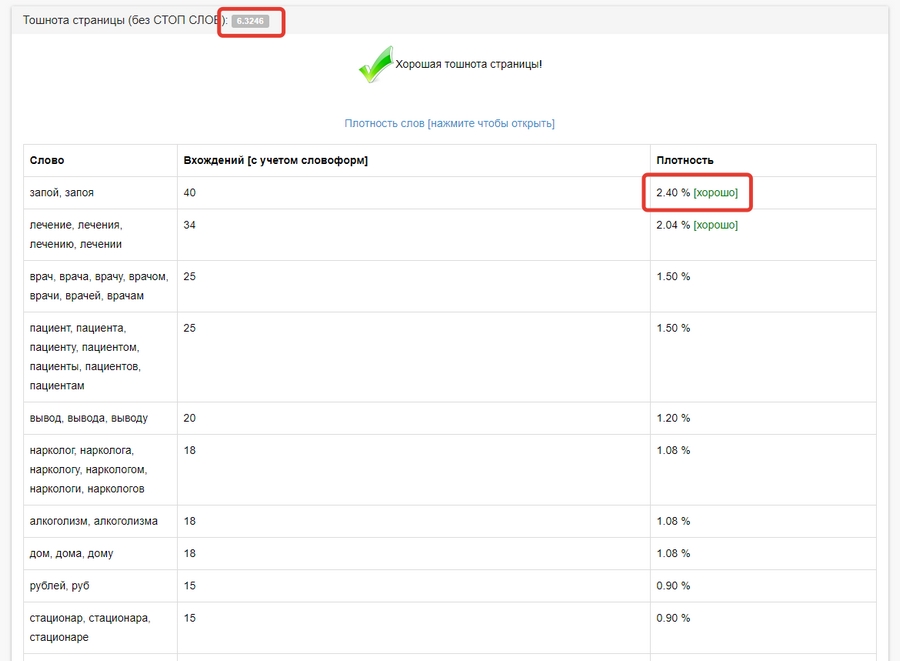

Обратим внимание на верхний блок и имеющиеся в нем строки: количество символов, тошнота, максимальная тошнота и минимальная тошнота. Мы вычислим эти значения для каждой из 10 страниц, а таблица посчитает среднее арифметическое. Так мы сможем увидеть тренды, в зависимости от которых страницы находятся в топе. Например, объем текста или плотность ключевых фраз.

Чуть ниже находятся два поля – бежевое и серое. Столбец формул левее этих полей представляет из себя переход от средней максимальной тошноты до средней минимальной тошноты, умноженный на 100 для удобства подсчетов.

В желтом поле будут находиться 5 страниц, возглавляющих топ, а в сером поле – замыкающая пятерка. Разница между первой и второй пятеркой заключается в их ранжировании. Первая пятерка имеет кратно превосходящий вес.

Все цифровые значения, которые мы получим в процессе работы, будем умножать на коэффициент. Для желтого поля он составит 1, а для серого – 0,5.

Справа внизу листа 1 – результаты нашей выборки, где каждому слову присваевается ранг. Чем выше ранг, тем ближе к максимальной тошноте должна быть плотность вхождений этого слова в тело документа. Чем ниже, тем ближе к минимуму, но все равно в интервале не меньше минимального.

Шаг 4. Парсинг LSI-фраз и обработка результатов

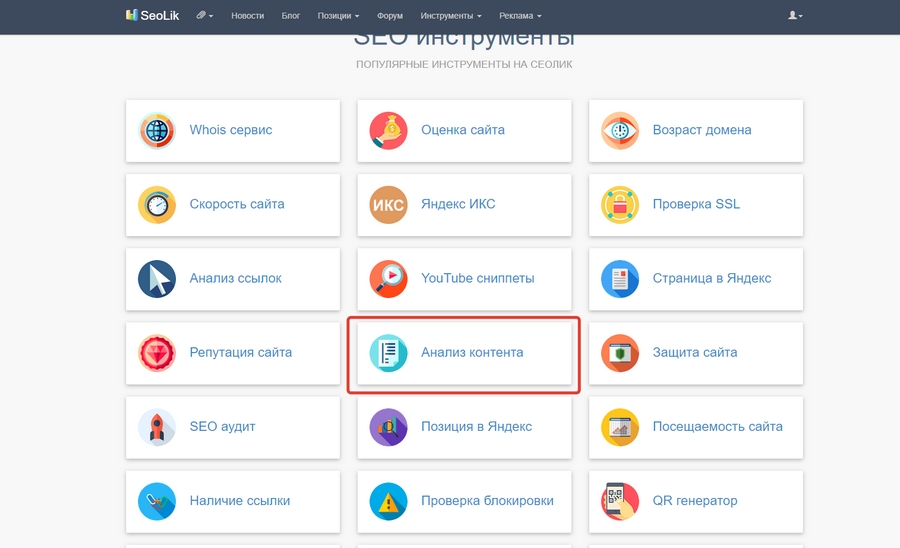

Переходим на сервис SeoLik (или его аналог p2pi) и находим инструмент «Анализ контента»:

Берем первую из десяти ссылок и вставляем в окошко для анализа контента страницы. В результатах ищем поля с картинок ниже и выписываем значения из них в таблицу в соответствующие ячейки:

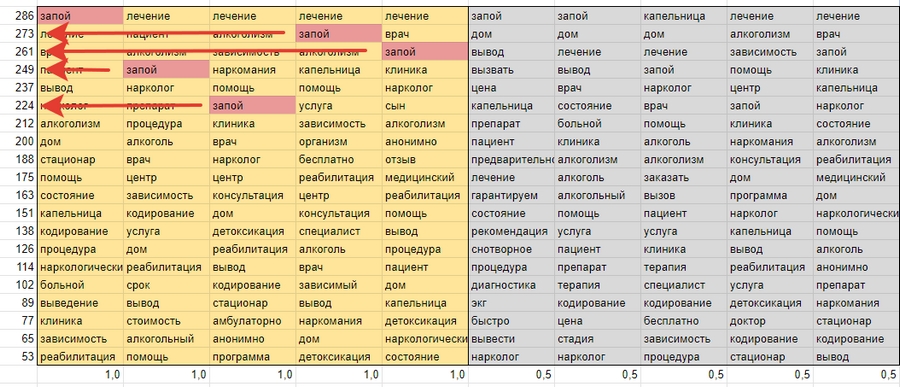

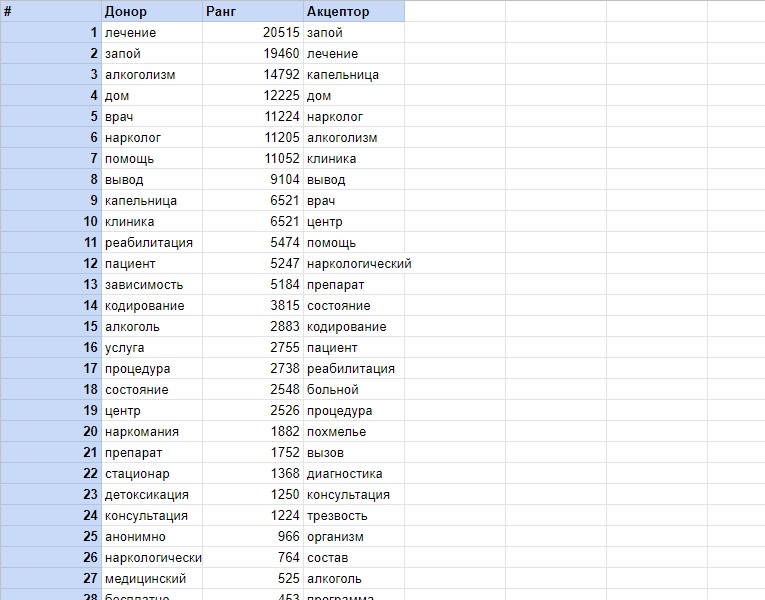

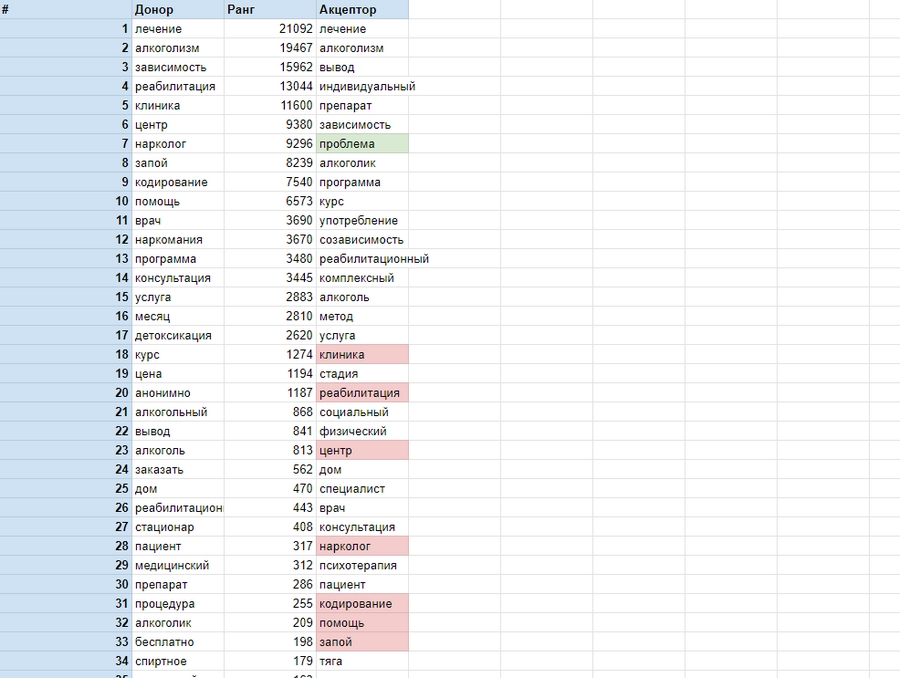

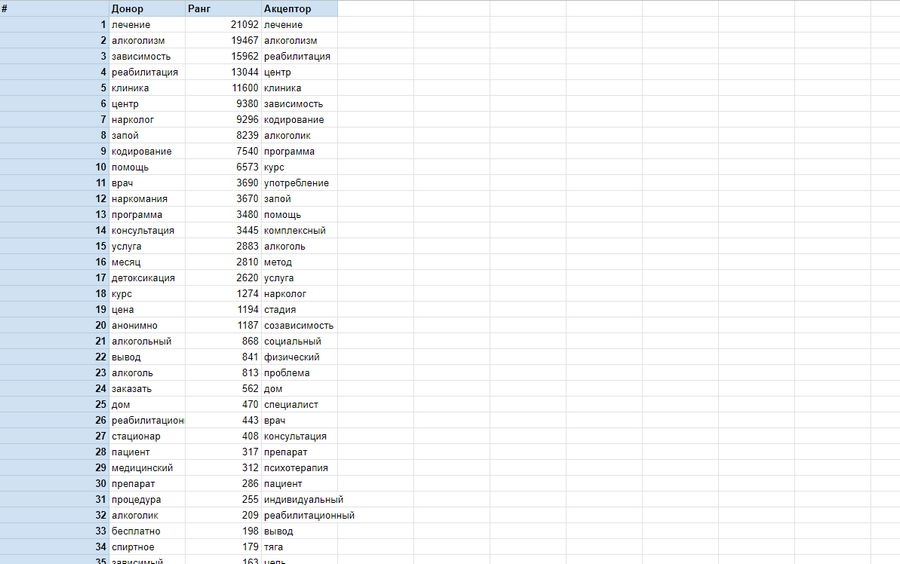

На второй картинке видим список слов. Выписываем первые 20 в желтое поле таблицы в столбик. Значение минимальной тошноты для этой страницы у нас будет равно тошноте 20-го слова: «запой», «лечение», «врач», «пациент» и т. д.

Ту же процедуру повторяем с остальными девятью страницами, постепенно заполняя желтое и серое поля:

Теперь остановимся на желтом поле.

Нам нужно найти одинаковые фразы в каждом из пяти столбиков, перемножить каждую на соответствующее ей число из столбика левее желтого поля. Считаем сумму полученных значений, вписываем слово и полученный результат в соответствующие ячейки справа. В столбец «Количество» вписываем число совпадений.

Ту же процедуру проделываем отдельно с серым полем, но результаты вычислений вписываем в столбец с коэффициентом 0,5:

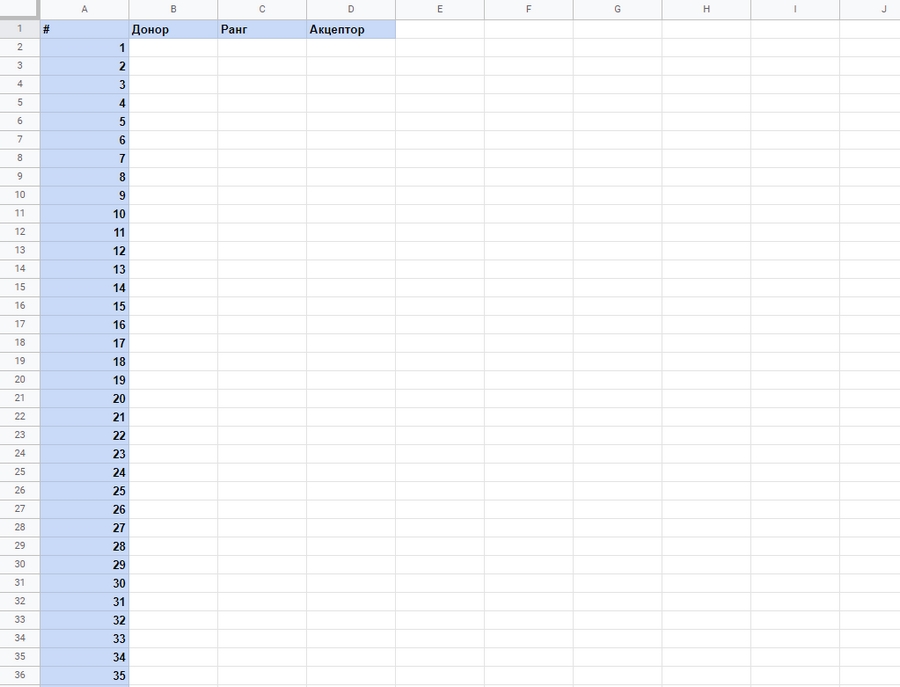

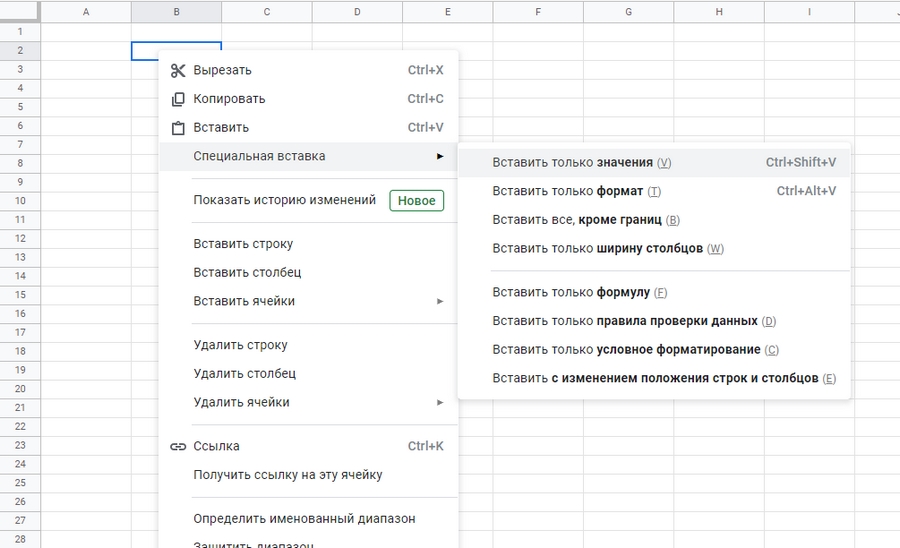

Копируем колонки «Фраза», «Количество» и «Ранг». Создаем новый лист в документе нажимам на ячейку B2 правой кнопкой мыши и выбираем «Специальная вставка» > «Вставить только значения»:

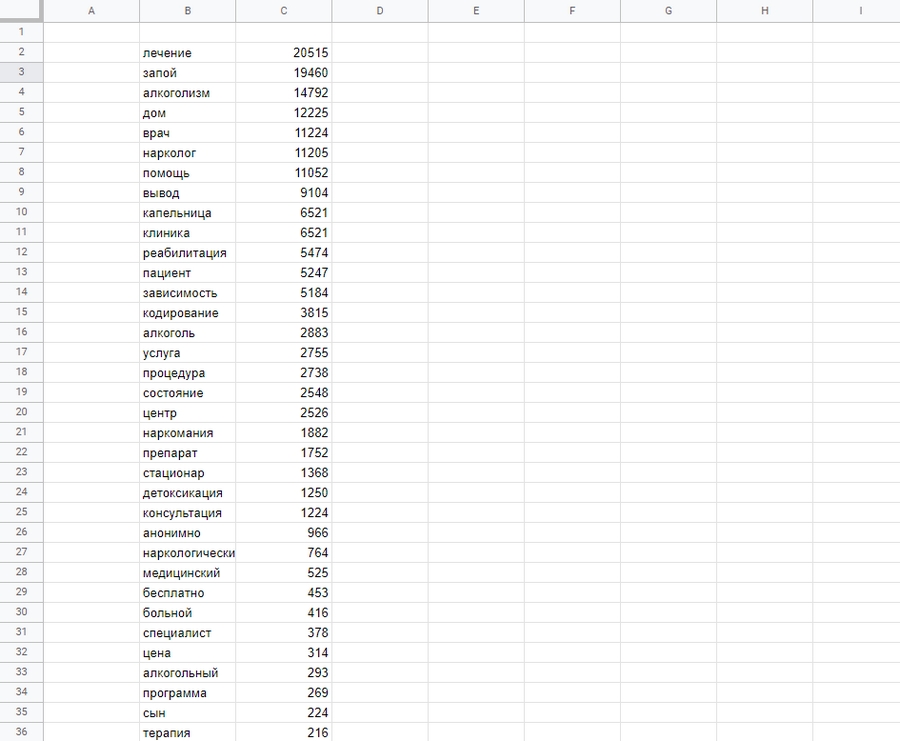

Удаляем столбец «Значения», фильтруем колонку «Ранг» от большего к меньшему. Получаем LSI-семантику. Располагаем слова по важности и узнаем плотность вхождений, которая у них должна быть:

Шаг 5. Сравнение

Теперь у нас два пути.

Шаг 6. Итог

Завершающий этап состоит в сравнении двух списков слов и «подтягивании» LSI-фраз, которые редко встречаются в теле нашей страницы, до необходимого уровня. Проверку проводим в SeoLik (или в p2pi), добавляем нужные фразы или убираем лишние до тех пор, пока столбец «Донор» и «Акцептор» не будут равны.

Сравним донорскую LSI-семантику с LSI-семантикой нашей страницы. Красным маркером пометим фразы, плотность вхождений которых нужно увеличить, а зеленым – слова, которые необходимо удалить:

Мы получили список: «клиника», «реабилитация», «центр», «нарколог», «кодирование», «помощь», «запой». Вписываем слова в текст страницы-акцептора. Проводим повторный анализ контента, получаем результаты, на которых видно, что список и ранг LSI-фраз донора и акцептора приблизительно равны, что и требовалось.

В Google и «Яндексе», соцсетях, рассылках, на видеоплатформах, у блогеров

LSI-копирайтинг. Принципы, инструменты, рекомендации

20 минут на чтение

Задача поисковых систем — найти информацию, которая наиболее точно отвечает запросам пользователя. Для этого машины должны были научиться распознавать смысл на основе содержания, а не только по отдельным «маякам» — поисковым запросам.

Классическая схема «запрос-документ» стала неактуальной из-за заспамленности большинства тематик. Поэтому ей на смену пришли алгоритмы латентного семантического анализа, а затем нейросети. В ответ специалисты SEO стали внедрять LSI-копирайтинг.

Цель — повышение релевантности, полезности, актуальности и достоверности материала. LSI-копирайтинг помогает поисковым системам лучше понимать смысл и содержание текста. В результате сайт может попасть на первые страницы выдачи, даже имея минимальное количество ключевых слов.

На практике это значит, что в тексте необходимо использовать синонимы основного запроса, сопутствующие ключевые слова и дополнительные фразы из смежных тематик. Это позволит полностью охватить и раскрыть тему. Такой контент оценят и пользователи, и поисковые системы.

История

В 1988 latent semantic analysis (LSA) получил патент U.S. Patent 4,839,853. Создатели метода — группа инженеров-исследователей: Скотт Дирвестер, Сьюзен Дюмэ, Джордж Фурнаш, Ричард Харшман, Томас Ландауэр, Карен Lochbaum и Линн Стритер.

Первоначально LSA применяли для выявления семантической структуры и автоматического индексирования текста. Затем — для построения когнитивных моделей и представления баз знаний. В США метод использовался для проверки качества обучающих методик и знаний школьников.

Суть метода

LSA, латентный семантический анализ — способ обработки информации на естественном языке. Он анализирует связь между коллекциями документов и терминами, которые в них встречаются. Латентный семантический анализ сопоставляет запросы и документы согласно тематике. Это позволяет выявлять скрытые ассоциативные и семантические связи.

LSI — аббревиатура от latent semantic indexing, с английского — латентное семантическое индексирование. Это способ использования LSA в области поиска информации.

Проще говоря, LSA позволяет машинам понимать смысл и содержание документа. А при ранжировании уравнивает «веса» разных по написанию, но близких по смыслу слов. Таким образом структурируются синонимы и запросы схожей тематики.

Основа системы — терм-документная матрица, разбор которой и является LSA. Терм-документная матрица представляет собой таблицу, в которой совмещаются «термы» (слова, фразы, термины) и документы. Строки соответствуют документам, а столбцы — терминам. Число обозначает количество пересечений.

LSI в алгоритмах поисковых систем

Первое упоминание LSA в поисковых системах связано с алгоритмом Panda от Google. Обновление ставило себе цель — найти и снизить количество контента низкого качества, который был создан с целью манипуляции поисковой выдачей. Алгоритм был запущен в феврале 2011, а уже в 2012 году появились первые упоминания об LSI-копирайтинге.

Окончательно новые требования к качеству текстов сформировались к 2013 году. В это время Google запустил новый алгоритм — Hummingbird («Колибри»). Главное отличие нового алгоритма — поиск стал понимать поисковые запросы разговорного типа. Google научился отыскивать нужные документы, исходя из семантических связей, а не просто по запросам.

«Яндекс» подхватил эстафету в ноябре 2016 года — запустил алгоритм «Палех». Его задача — распознавать низкочастотные и сложные запросы из «длинного хвоста». То есть понимать запросы в разговорном ключе. Общая масса таких запросов составляет порядка 40% от объема текста.

Для работы алгоритма были использованы нейросети и машинное обучение. Подробнее о механике и принципах работы алгоритма можно прочитать в блоге «Яндекс» на Хабрахабре. Введение в работу «Палеха» подогрело интерес к LSI-текстам в русскоязычном интернете.

Весной 2017 года «Яндекс» вводит «Баден-Баден» — новый алгоритм определения текстов, которые перенасыщены ключевыми словами. Тысячи сайтов попадают под фильтр и понижаются в выдаче, условием возврата трафика называется отказ от SEO-текстов.

Осенью 2017 «Яндекс» запускает «Королев» — алгоритм поиска на основе нейросетей. По заявлению «Яндекс», алгоритм «…сопоставляет смысл запросов и веб-страниц…». Новый алгоритм работает на нейросетях, но при этом не отменяет LSI, а усиливает сложившиеся тенденции. Теперь писать SEO-тексты нет никакого смысла — вместо топа можно получить фильтр за переоптимизацию.

Что такое LSI-тексты и как правильно их писать?

В переводе с английского latent semantic indexing (LSI) означает скрытая семантическая индексация. Если простыми словами, LSI-тексты – это публикации, эффективно раскрывающие тему ключевого запроса, но помимо основного семантического ядра в них присутствуют синонимы, около тематические словоформы и фразы. А зачем они нужны? Как всегда, чтобы повысить рейтинг веб-страницы/сайта в поисковой выдаче.

К появлению LSI-текстов привела эволюция поисковых систем

Было время, когда поисковые системы выдавали пользователю страницы, соответствующие его запросу, учитывая прямое вхождение ключевых фраз. Некоторые оптимизаторы выходили за адекватные рамки, используя переспам. В результате тексты напоминали сплошное полотно ключевых слов, среди которых кое-где просматривалась полезная информация.

Что изменилось? Первым вышел на арену алгоритм пессимизации Google – Panda в 2011 г. Он стал понижать низкокачественные ресурсы в поисковой выдаче, анализируя множество факторов, в том числе количество ключевых слов. Затем в 2013 г. появился алгоритм ранжирования Hummingbird («Колибри»), который научился распознавать намерения пользователей.

Дальше вышли алгоритмы Яндекса – «Палех», «Королев», «Баден-Баден». Их общая цель: борьба с переоптимизированными текстами и понимание поисковыми роботами «естественного языка» пользователей интернетом.

Среди технологий, используемых поисковыми роботами для распознавания смысла пользовательских запросов, выделяют LSI. Она анализирует контекст, чтобы распознать о чём идёт речь на странице сайта.

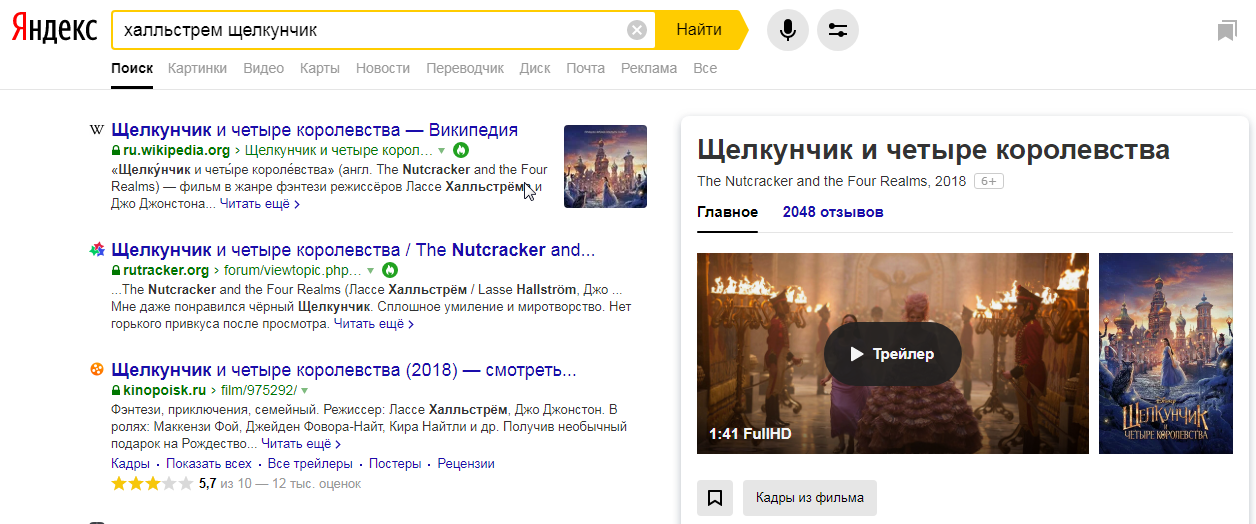

Приведу пример. Я ввожу в строку поиска имя режиссера и слово из названия киноленты. Поисковик понимает, что имеется ввиду не книга, балет или кинопроизведения других лет, а именно фильм «Щелкунчик и четыре королевства».

Пример скрытой семантической индексации

Как создавать LSI-тексты правильно?

Наилучший вариант – выбрать автора, который хорошо разбирается в нужной вам теме или хотя бы умеет работать с экспертными мнениями в сети. Тогда ему достаточно ключевых запросов, чтобы создать интересный и полезный контент. Он сможет самостоятельно подобрать слова и фразы, связанные с основным запросом по смыслу, и раскрыть тему естественным образом. В результате даже появилась новая сфера деятельности LSI-копирайтинг.

К сожалению, этот вариант редко используется заказчиками. Как правило, рядовой копирайтер не фокусируется на раскрытии темы, а просто «сдирает» наиболее подходящую по теме информацию с других источников.

В таком случае требуется составление ТЗ, в котором для копирайтера прописываются:

Требования к LSI-текстам

Некоторые считают, что LSI-статья в любом случае будет полезной. Нет! Бездумное внедрение LSI-слов максимум станет эффективным для продвижения. И то не факт – низкокачественный и неполезный контент не получит большого объёма внешних ссылок, не привлечёт много трафика и не покажет отличных поведенческих факторов. А все мы знаем, что данные показатели в комплексе с контентом оказывают влияние на успешное продвижение в поиске.

Итак, LSI-тексты должны:

Объём и структура текста с дополнительной релевантной семантикой

Тут всё просто. Зачастую хороший контент не ограничивается килознаками – его длина определяется таким образом, чтобы дать развёрнутый ответ по теме.

Статья должна быть структурированной: заголовки, подзаголовки, списки перечисления. Дополнительные моменты: последовательность изложения, при необходимости сравнение двух продуктов/услуг, анализ преимуществ и недостатков, заключение.

Как подбирать LSI-ключи?

Повторюсь, LSI-запросы – это не только синонимы, но и словоформы, сопутствующие заданной теме. Для поиска таких запросов есть масса инструментов, как платных, так и бесплатных. Начнём с халявы.

Бесплатные инструменты

Поисковые подсказки Яндекса

Смотрите правую колонку сервиса – «Запросы, похожие на …» Отсюда выбираются словосочетания, подходящие по теме.

Яндекс.Вордстат «Запросы, похожие на …»

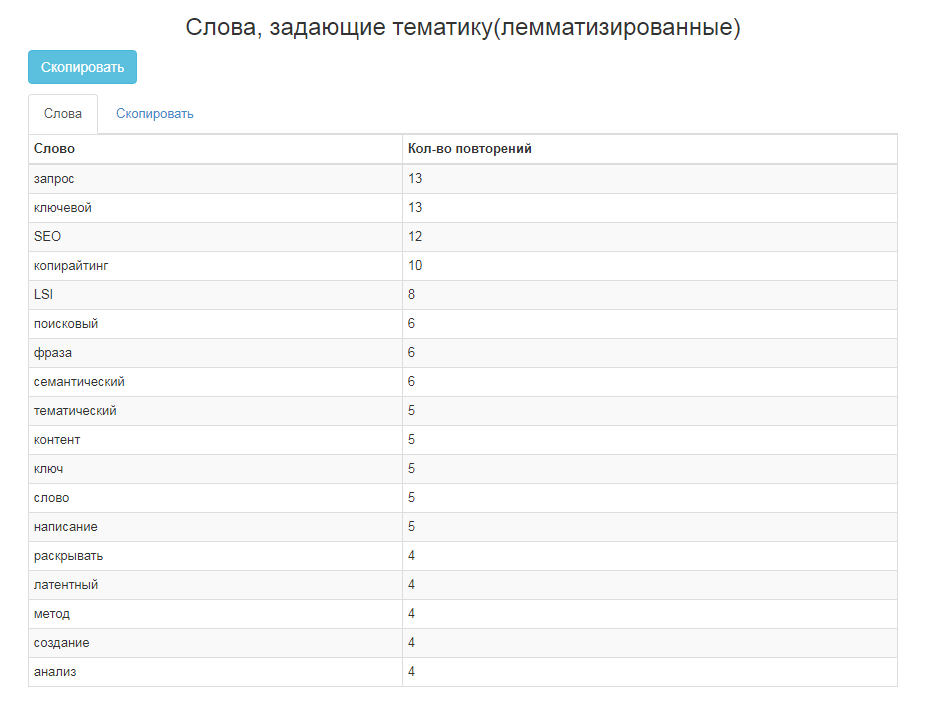

На портале много инструментов, но в данном случае нас интересует «Парсинг подсветок Yandex и сбор тематических слов». Правда в бесплатной версии есть ограничения.

Парсинг подсветок Яндекса и сбор тематических слов от Арсенкина

Вводите продвигаемый запрос. В соответствующем окне вы получаете список слов, задающих тематику.

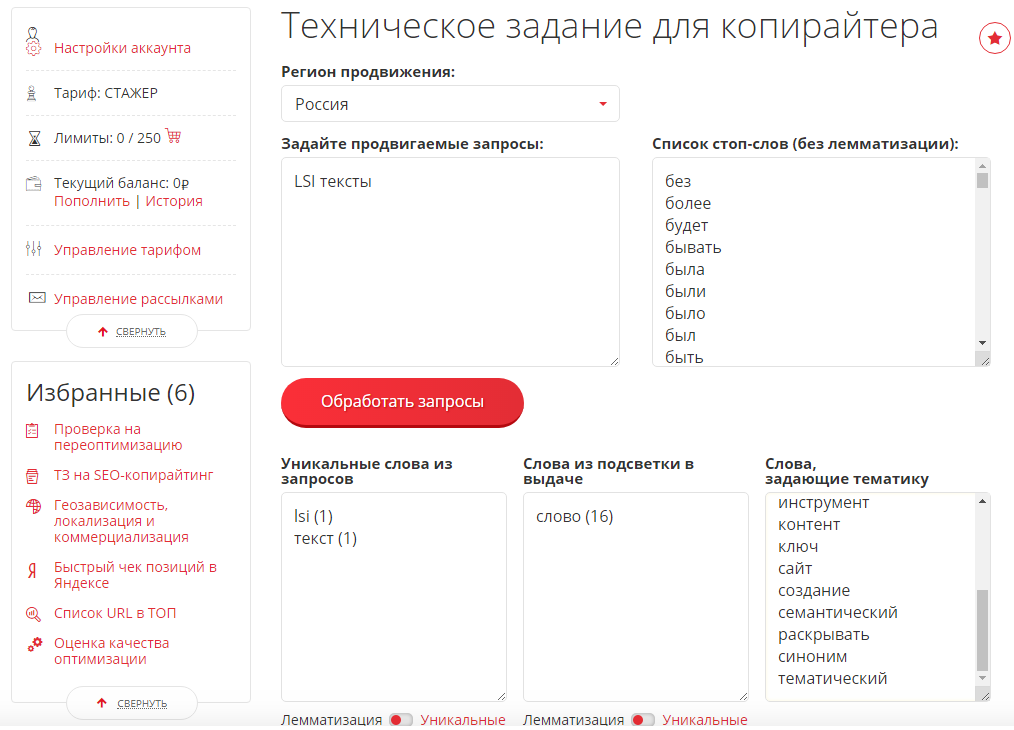

Техническое задание для копирайтера от Pixel Tools

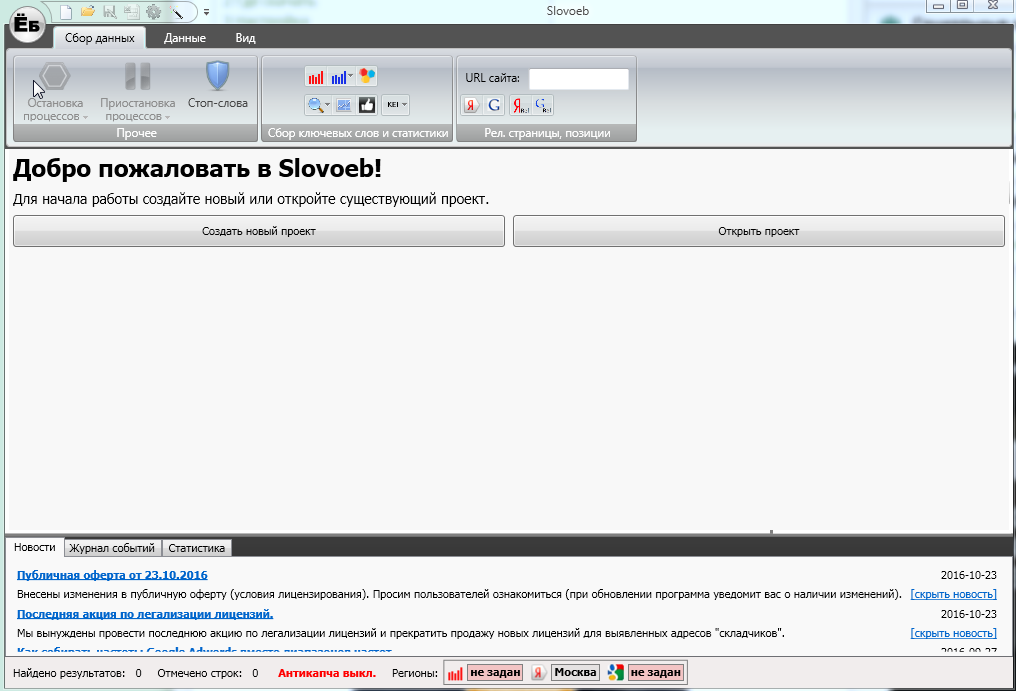

Отличный бесплатный инструмент – аналог Key Collector. Программу нужно скачивать. Она автоматически парсит запросы с Яндекс.Вордстата, Директа и других сервисов для расширения семантического ядра.

Интерфейс программы Slovoeb

Платные инструменты

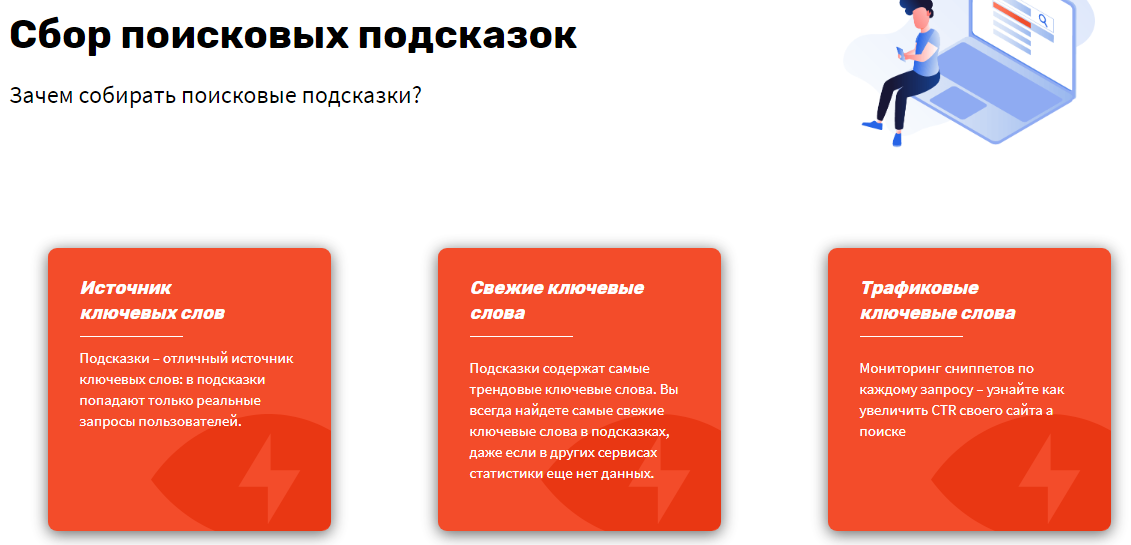

Парсер собирает подсказки из Google, YouTube и Яндекса, автоматически отсеивает мусорные запросы.

Сбор поисковых подсказок от Rush Analytics

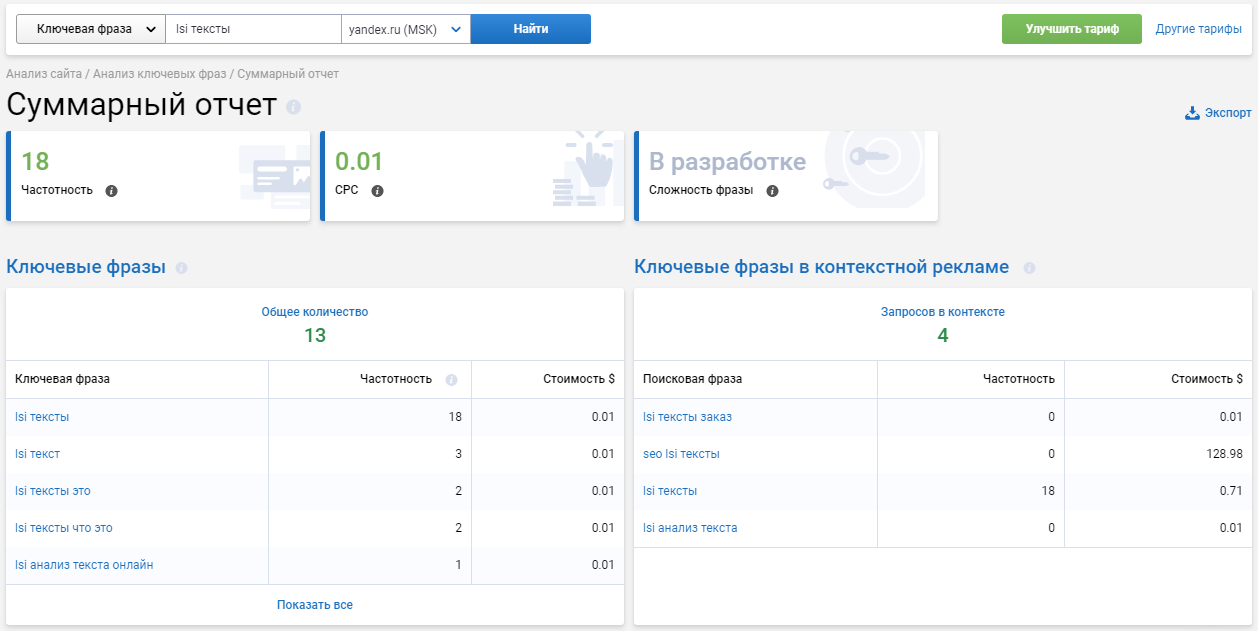

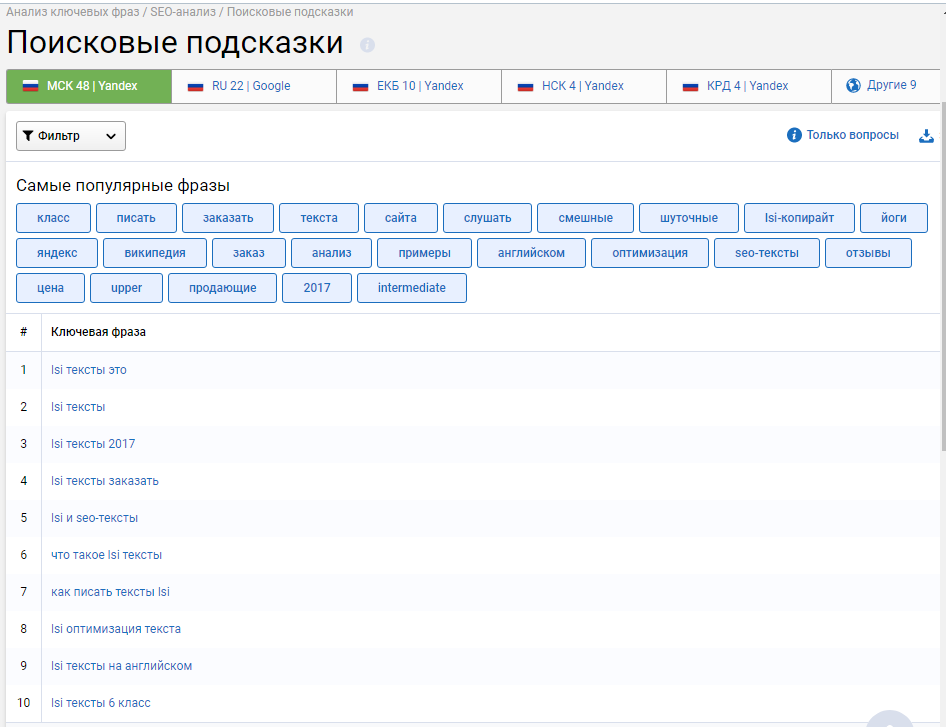

Многофункциональный сервис, в котором также есть инструменты по анализу ключевых фраз – суммарный отчёт, подбор фраз, поисковые подсказки, похожие фразы.

Суммарный отчет от SerpStat

Поисковые подсказки в SerpStat

Помимо стандартных инструментов для парсинга вы получаете опции, позволяющие автоматизировать и упростить сам процесс.

Функционал подбора ключевых слов от Click.ru

Пример LSI-текстов

Допустим, я решил написать текст о том, как хранить кофе. Работа ведётся поэтапно.

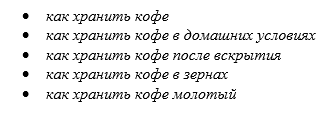

1 этап: сбор локального семантического ядра по теме. Вот что получилось.

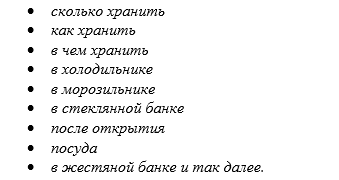

2 этап: сбор ассоциаций, синонимов, гипонимов и около тематических слов 1 порядка для каждого из ключевых запросов. Возьмём запрос «как хранить кофе в домашних условиях» и соберём для него LSI-запросы.

3 этап: сбор LSI-запросов 2 порядка по каждому из предыдущих ключей. Рассмотрим на примере «в холодильнике».

Слова и словосочетания 1 и 2 порядка могут перекликаться между собой. На практике вы видите последовательность работы. К сожалению, пока ни одна программа не может выполнить её лучше человека, потому что бездумное использование ключевых слов приводит к топорным и нечитабельным текстам. Сервисы только помогают расширить ядро для дальнейшего анализа.

На основании собранных данных структура публикации может быть следующей.

Пример структуры LSI-статьи

Вывод

LSI-тексты – не новая технология, а современный и правильный подход к созданию читабельного и полезного контента в комплексе с работами по SEO-оптимизации. Цель данной методики – написание текстов согласно требованиям поисковых систем и потребностям читателей.

Отсюда вытекают основные преимущества: