Что такое достаточность информации

Что такое достаточность информации

Информатика рассматривает информацию как концептуально связанные между собой сведения, данные, понятия, изменяющие наши представления о явлении или объекте окружающего мира. Наряду c информацией в информатике часто употребляется понятие данные. Покажем, в чем их отличие.

Данные могут рассматриваться как признаки или записанные наблюдения, которые по каким-то причинам не используются, а только хранятся. В том случае, если появляется возможность использовать эти данные для уменьшения неопределенности о чем-либо, данные превращаются в информацию. Поэтому можно утверждать, что информацией являются используемые данные.

Пример 2.1. Напишите на листе десять номеров телефонов в виде последовательности десяти чисел и покажите их вашему другу. Он воспримет эти цифры как данные, так как они не предоставляют ему никаких сведений

Затем против каждого номера укажите название фирмы и род деятельности. Для вашего друга непонятные цифры обретут определенность и превратятся из данных в информацию, которую он в дальнейшем мог бы использовать.

При работе с информацией всегда имеется ее источник и потребитель (получатель). Пути и процессы, обеспечивающие передачу сообщений от источника информации к ее потребителю, называются информационными коммуникациями.

Для потребителя информации очень важной характеристикой является ее адекватность.

В реальной жизни вряд ли возможна ситуация, когда вы сможете рассчитывать на полную адекватность информации. Всегда присутствует некоторая степень неопределенности. От степени адекватности информации реальному состоянию объекта или процесса зависит правильность принятия решений человеком.

Пример 2.2. Вы успешно закончили школу и хотите продолжить образование по экономическому направлению. Поговорив с друзьями, вы узнаете, что подобную подготовку можно получить в разных вузах. В результате таких бесед вы получаете весьма разноречивые сведения, которые не позволяют вам принять решение в пользу того или иного варианта, т.е. полученная информация неадекватна реальному состоянию дел. Для того чтобы получить более достоверные сведения, вы покупаете справочник для поступающих в вузы, из которого получаете исчерпывающую информацию. В этом случае можно говорить, что информация, полученная вами из справочника, адекватно отражает направления обучения в вузах и помогает вам определиться в окончательном выборе.

ФОРМЫ АДЕКВАТНОСТИ ИНФОРМАЦИИ

Адекватность информации может выражаться в трех формах: семантической, синтаксической, прагматической.

Синтаксическая адекватность. Она отображает формально-структурные характеристики информации и не затрагивает ее смыслового содержания. На синтаксическом уровне учитываются тип носителя и способ представления информации, скорость передачи и обработки, размеры кодов представления информации, надежность и точность преобразования этих кодов и т.п. Информацию, рассматриваемую только с синтаксических позиций, обычно называют данными, так как при этом не имеет значения смысловая сторона. Эта форма способствует восприятию внешних структурных характеристик, т.е. синтаксической стороны информации.

Семантическая (смысловая) адекватность. Эта форма определяет степень соответствия образа объекта и самого объекта. Семантический аспект предполагает учет смыслового содержания информации. На этом уровне анализируются те сведения, которые отражает информация, рассматриваются смысловые связи. В информатике устанавливаются смысловые связи между кодами представления информации. Эта форма служит для формирования понятий и представлений, выявления смысла, содержания информации и ее обобщения.

Прагматическая (потребительская) адекватность. Она отражает отношение информации и ее потребителя, соответствие информации цели управления, которая на ее основе реализуется. Проявляются прагматические свойства информации только при наличии единства информации (объекта), пользователя и цели управления. Прагматический аспект рассмотрения связан с ценностью, полезностью использования информации при выработке потребителем решения для достижения своей цели. С этой точки зрения анализируются потребительские свойства информации. Эта форма адекватности непосредственно связана с практическим использованием информации, с соответствием ее целевой функции деятельности системы.

МЕРЫ ИНФОРМАЦИИ

Классификация мер

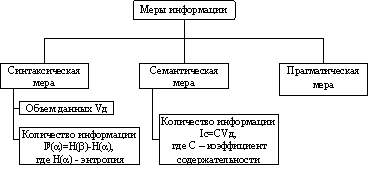

Для измерения информации вводятся два параметра: количество информации I и объем данных Vд.

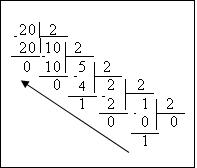

Эти параметры имеют разные выражения и интерпретацию в зависимости от рассматриваемой формы адекватности. Каждой форме адекватности соответствует своя мера количества информации и объема данных (рис. 2.1).

Рис. 2.1. Меры информации

Синтаксическая мера информации

Эта мера количества информации оперирует с обезличенной информацией, не выражающей смыслового отношения к объекту.

Объем данных Vд. в сообщении измеряется количеством символов (разрядов) в этом сообщении. В различных системах счисления один разряд имеет различный вес и соответственно меняется единица измерения данных:

Примечание. В современных ЭВМ наряду с минимальной единицей измерения данных «бит» широко используется укрупненная единица измерения «байт», равная 8 бит.

Пример 2.3. Сообщение в двоичной системе в виде восьмиразрядного двоичного кода 10111011 имеет объем данных Vд=8 бит.

Сообщение в десятичной системе в виде шестиразрядного числа 275903 имеет объем данных Vд=6 дит.

Количество информации — на синтаксическом уровне невозможно определить без рассмотрения понятия неопределенности состояния системы (энтропии системы). Действительно, получение информации о какой-либо системе всегда связано с изменением степени неосведомленности получателя о состоянии этой системы. Рассмотрим это понятие.

Пусть до получения информации потребитель имеет некоторые предварительные (априорные) сведения о системе a. Мерой его неосведомленности о системе является функция H(a), которая в то же время служит и мерой неопределенности состояния системы.

После получения некоторого сообщения b получатель приобрел некоторую дополнительную информацию Ib(a), уменьшившую его априорную неосведомленность так, что апостериорная (после получения сообщения b) неопределенность состояния системы стала Hb(a).

Тогда количество информации Ib(a) о системе, полученной в сообщении b, определится как

т.е. количество информации измеряется изменением (уменьшением) неопределенности состояния системы.

Если конечная неопределенность Hb(a) обратится в нуль, то первоначальное неполное знание заменится полным знанием и количество информации Ib(a)=H(a). Иными словами, энтропия системы H(a) может рассматриваться как мера недостающей информации.

Энтропия системы H(a), имеющая N возможных состояний, согласно формуле Шеннона, равна:

где Рi — вероятность того, что система находится в i-м состоянии.

Для случая, когда все состояния системы равновероятны, т.е. их вероятности равны Pi=1/N, ее энтропия определяется соотношением

Часто информация кодируется числовыми кодами в той или иной системе счисления, особенно это актуально при представлении информации в компьютере. Естественно, что одно и то же количество разрядов в разных системах счисления может передать разное число состояний отображаемого объекта, что можно представить в виде соотношения

Пример 2.4. Но каналу связи передается n-разрядное сообщение, использующее т различных символов. Так как количество всевозможных кодовых комбинаций будет N=m n , то при равновероятности появления любой из них количество информации, приобретенной абонентом в результате получения сообщения, будет I=logN=logm — формула Хартли.

Если в качестве основания логарифма принять т, то I=n. В данном случае количество информации (при условии полного априорного незнания абонентом содержания сообщения) будет равно объему данных I=Vд, полученных по каналу связи. Для неравновероятных состояний системы всегда I Коэффициент (степень) информативности (лаконичность) сообщения определяется отношением количества информации к объему данных, т.е.

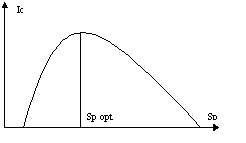

В зависимости от соотношений между смысловым содержанием информации S и тезаурусом пользователя Sp изменяется количество семантической информации Ic, воспринимаемой пользователем и включаемой им в дальнейшем в свой тезаурус. Характер такой зависимости показан на рис.2.2. Рассмотрим два предельных случая, когда количество семантической информации Ic равно 0:

при Sp 0 пользователь не воспринимает, не понимает поступающую информацию;

при Sp; пользователь все знает, н поступающая информация ему не нужна.

Рис. 2.2. Зависимость количества семантической информации. воспринимаемой потребителем, от его тезауруса Ic=f(Sp)

Максимальное количество семантической информации Ic потребитель приобретает при согласовании ее смыслового содержания S со своим тезаурусом Sp (Sp = Sp opt), когда поступающая информация понятна пользователю и несет ему ранее не известные (отсутствующие в его тезаурусе) сведения.

Следовательно, количество семантической информации в сообщении, количество новых знаний, получаемых пользователем, является величиной относительной. Одно и то же сообщение может иметь смысловое содержание для компетентного пользователя и быть бессмысленным (семантический шум) для пользователя некомпетентного.

При оценке семантического (содержательного) аспекта информации необходимо стремиться к согласованию величин S и Sp.

Относительной мерой количества семантической информации может служить коэффициент содержательности С, который определяется как отношение количества семантической информации к ее объему:

Прагматическая мера информации

Эта мера определяет полезность информации (ценность) для достижения пользователем поставленной цели. Эта мера также величина относительная, обусловленная особенностями использования этой информации в той или иной системе. Ценность информации целесообразно измерять в тех же самых единицах (или близких к ним), в которых измеряется целевая функция.

Пример 2.5. В экономической системе прагматические свойства (ценность) информации можно определить приростом экономического эффекта функционирования, достигнутым благодаря использованию этой информации для управления системой:

Для сопоставления введенные меры информации представим в табл.2.1.

Таблица 2.1. Единицы измерения информации и примеры

Мера информации

Единицы измерения

Примеры

(для компьютерной области)

Степень уменьшения неопределенности

Единицы представления информации

Пакет прикладных программ, персональный компьютер, компьютерные сети и т.д.

Рентабельность, производительность, коэффициент амортизации и т.д.

Емкость памяти, производительность компьютера, скорость передачи данных и т.д.

Время обработки информации и принятия решений

КАЧЕСТВО ИНФОРМАЦИИ

Возможность и эффективность использования информации обусловливаются такими основными ее потребительскими показателями качества, как репрезентативность, содержательность, достаточность, доступность, актуальность, своевременность, точность, достоверность, устойчивость.

С увеличением содержательности информации растет семантическая пропускная способность информационной системы, так как для получения одних и тех же сведений требуется преобразовать меньший объем данных.

Наряду с коэффициентом содержательности С, отражающим семантический аспект, можно использовать и коэффициент информативности, характеризующийся отношением количества синтаксической информации (по Шеннону) к объему данных Y=I/Vд.

Достоверность информации определяется ее свойством отражать реально существующие объекты с необходимой точностью. Измеряется достоверность информации доверительной вероятностью необходимой точности, т.е. вероятностью того, что отображаемое информацией значение параметра отличается от истинного значения этого параметра в пределах необходимой точности.

Устойчивость информации отражает ее способность реагировать на изменения исходных данных без нарушения необходимой точности. Устойчивость информации, как и репрезентативность, обусловлена выбранной методикой ее отбора и формирования.

В заключение следует отметить, что такие параметры качества информации, как репрезентативность, содержательность, достаточность, доступность, устойчивость, целиком определяются на методическом уровне разработки информационных систем. Параметры актуальности, своевременности, точности и достоверности обусловливаются в большей степени также на методическом уровне, однако на их величину существенно влияет и характер функционирования системы, в первую очередь ее надежность. При этом параметры актуальности и точности жестко связаны соответственно с параметрами своевременности и достоверности.

Что такое достаточность информации

Строго научного определения, что такое информация не существует. Разные люди при разных обстоятельствах могут вкладывать в это понятие разный смысл. В бытовом смысле информация – это сведения, которые человек получает от окружающего мира с помощью органов чувств. Для математика понятие информации шире. Информация – это те сведения, которые человек создал сам с помощью умозаключений. (Теоремы, Постулаты, Аксиомы). Для биолога к информации относятся и те данные, которые человек хранит в себе с момента рождения и до самой смерти. Это генетический код, благодаря которому дети так похожи на своих родителей.

Итак, в разных научных дисциплинах и в разных областях техники существуют разные понятия об информации. Но все отрасли сходятся в том, что информацию необходимо создавать, передавать, принимать, хранить и обрабатывать. Вот это и есть задачи информатики.

Информатика – это техническая наука, изучающая способы создания, хранения, обработки и передачи (и защиты) информации средствами вычислительной техники.

Возникнув как наука об информации, информатика в настоящее время развивается по многим другим направлениям. Предмет информатики точно невозможно определить – он сложный, многосторонний, динамичный.

Предметная область информатики

Теоретическая информатика (Brainware)

Этот раздел информатики использует математические методы для общего изучения процессов обработки информации.

Теория алгоритмов

Прикладная информатика

(Software)

изучением закономерностей в информационных процессах (накопление, переработка, распространение);

созданием информационных моделей коммуникаций в различных областях человеческой деятельности;

разработкой информационных систем и технологий в конкретных областях и выработкой рекомендаций относительно их жизненного цикла: для этапов проектирования и разработки систем, их производства, функционирования и т.д.

Технические средства (Hardware)

раздел, в котором разрабатываются общие принципы построения вычислительных систем. Речь идет не о технических деталях и электронных схемах (это лежит за пределами информатики как таковой), а о принципиальных решениях на уровне, так называемой, архитектуры вычислительных (компьютерных) систем, определяющей состав, назначение, функциональные возможности и принципы взаимодействия устройств.

2. Свойства информации

2.1. Качественные характеристики информации

Основные свойства информации:

Адекватность – это степень соответствия создаваемого с помощью полученной информации образа реальному объекту, процессу, явлению и т.п.

Доступность – это мера возможности получить ту или иную информацию.

Понятность

Достоверность

Массовость

Устойчивость

Ценность

2.2. Количественные характеристики информации

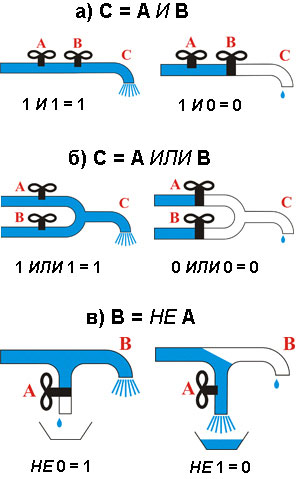

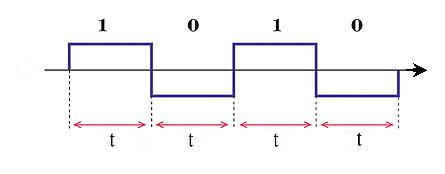

Т.е. наименьшая единица информации принимает значение либо 0, либо 1.

Т.е. наименьшая единица информации принимает значение либо 0, либо 1.